独家|AI技术干货!从头开始图解大语言模型

在阅读本文前,有几个热身的问题,您尝试回答一下。

2. 大语言模型开发与传统机器学习开发有什么区别?

3. 什么是任务特定模型?

4. 什么是大语言模型的微调和参数有效调整?

下面就让我们开启探讨大语言模型奥秘之旅。

引言

下面我们通过几个通俗易懂的示例,逐步对大模型的工作机理展开进行讲解,希望能够让更多的读者掌握相关的背景知识。

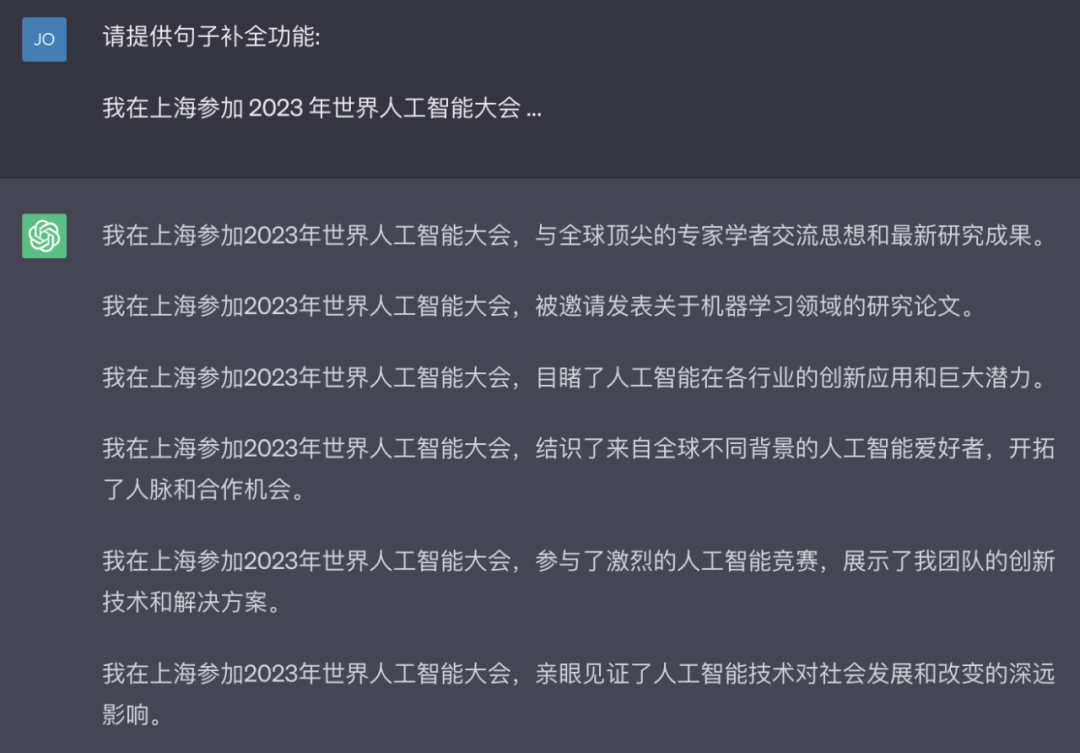

根据使用频率进行字词的推荐

首先,让我们以平时使用手机时的场景作为起点,相信大家一定会对手机输入法的自动补全功能有所了解。不知你有没有想过它到底是如何工作的呢?举例来说,当输入"我“之后,系统会提供一些后续词语建议,比如”在“、”的“、”现在“等。为什么会推荐这几个字或词组呢?因为,这些组合是我们经常用到的,在日常生活中,使用频率极高。

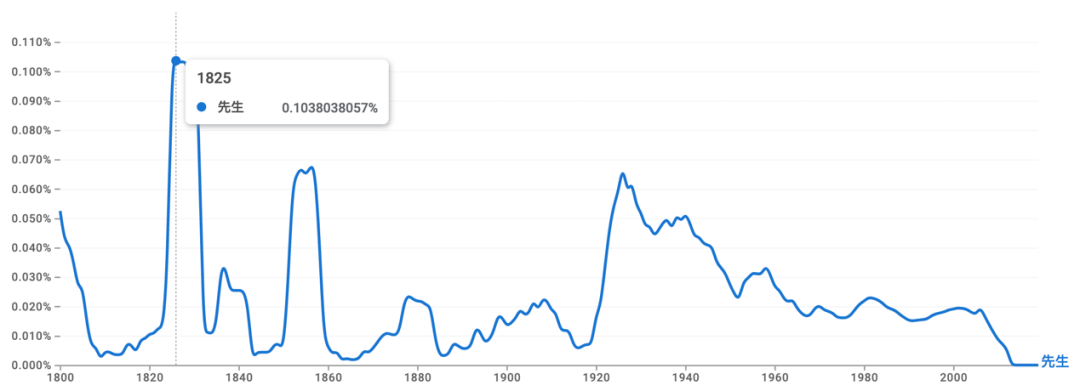

字词使用频率是动态变化的

在社会的发展和演进过程中,词汇的使用频率会随着时间的推移而变化。在这个过程中,有些词汇可能会逐渐被淘汰,而一些新的词汇又会出现。举个例子,英文单词"tye"在19世纪初期的使用频率相当高,然而在今天,你可能需要阅读几千万字才能偶然遇到一次。再比如,中文的“先生”一词,随着社会的变化和语言的发展,这个词在不同的时期,其使用的场景和频率也会有很大差别。另外,在科技发展迅速的今天,许多科技相关的新词汇被创造出来,并被广泛使用,比如“互联网”,“智能手机”,“人工智能”和“类脑计算”等等。

深入剖析文本生成的机理

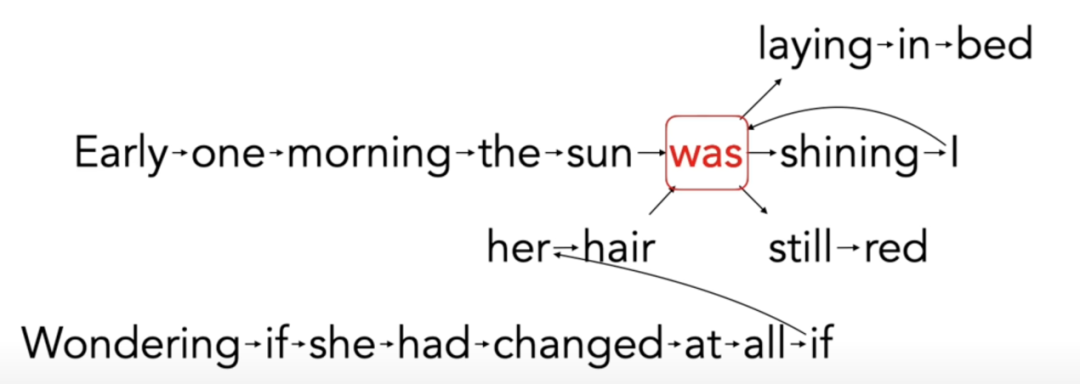

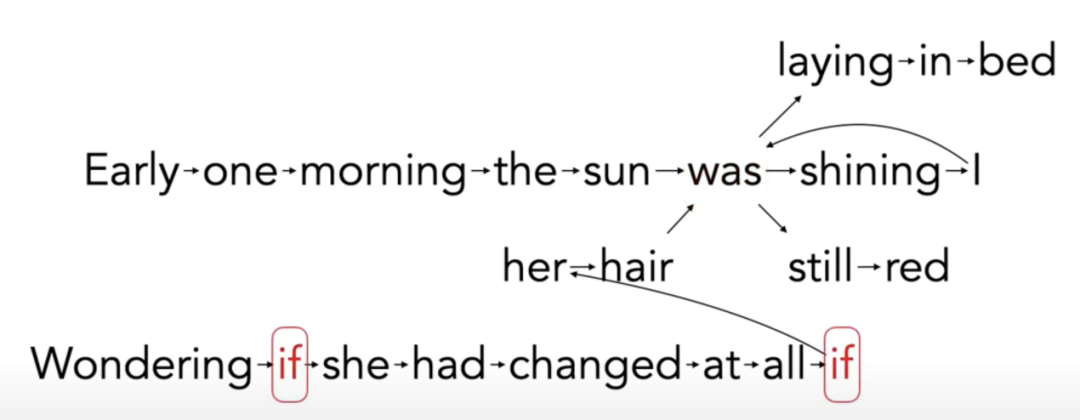

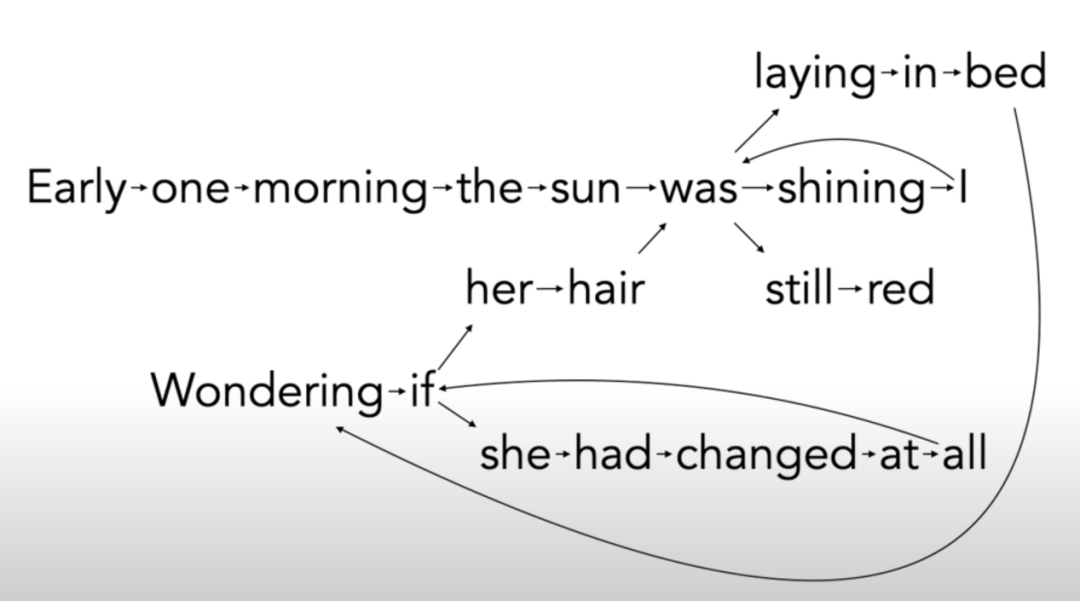

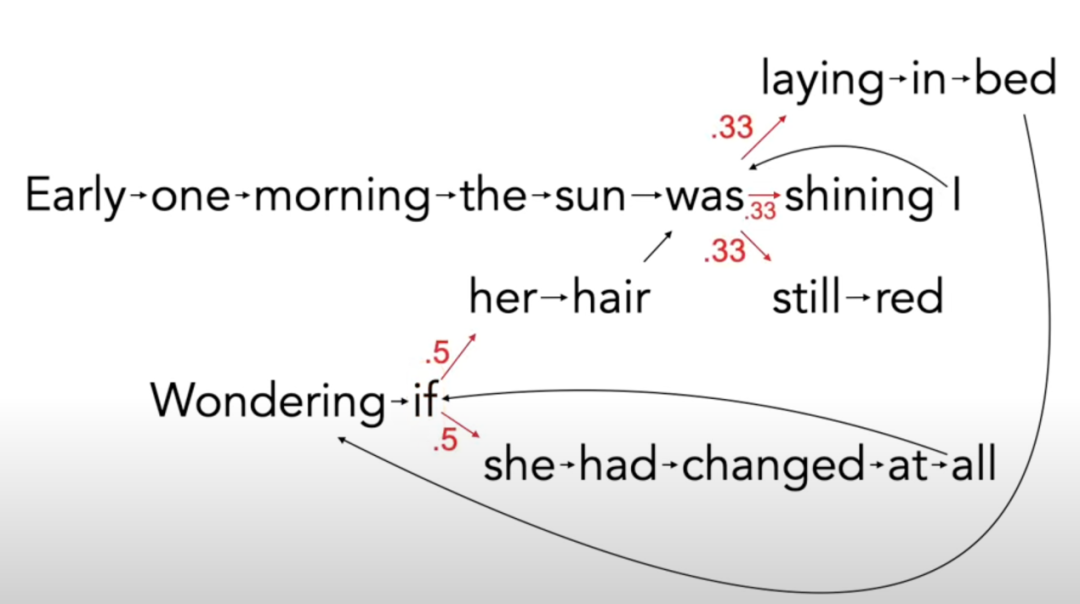

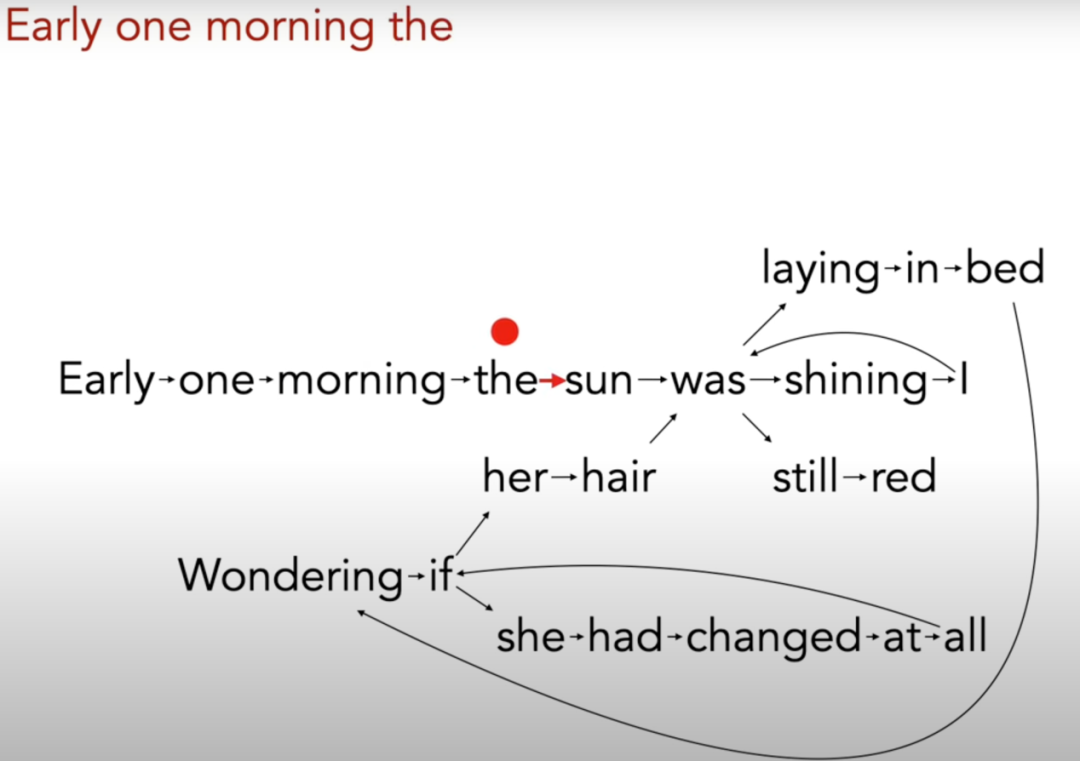

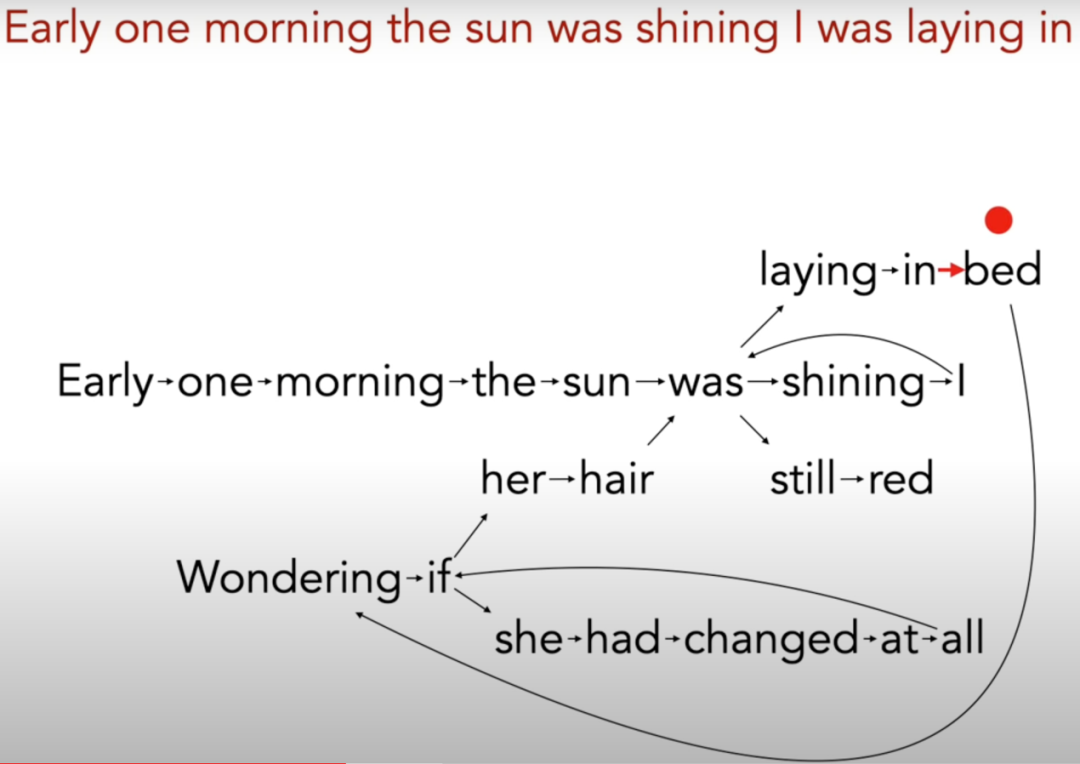

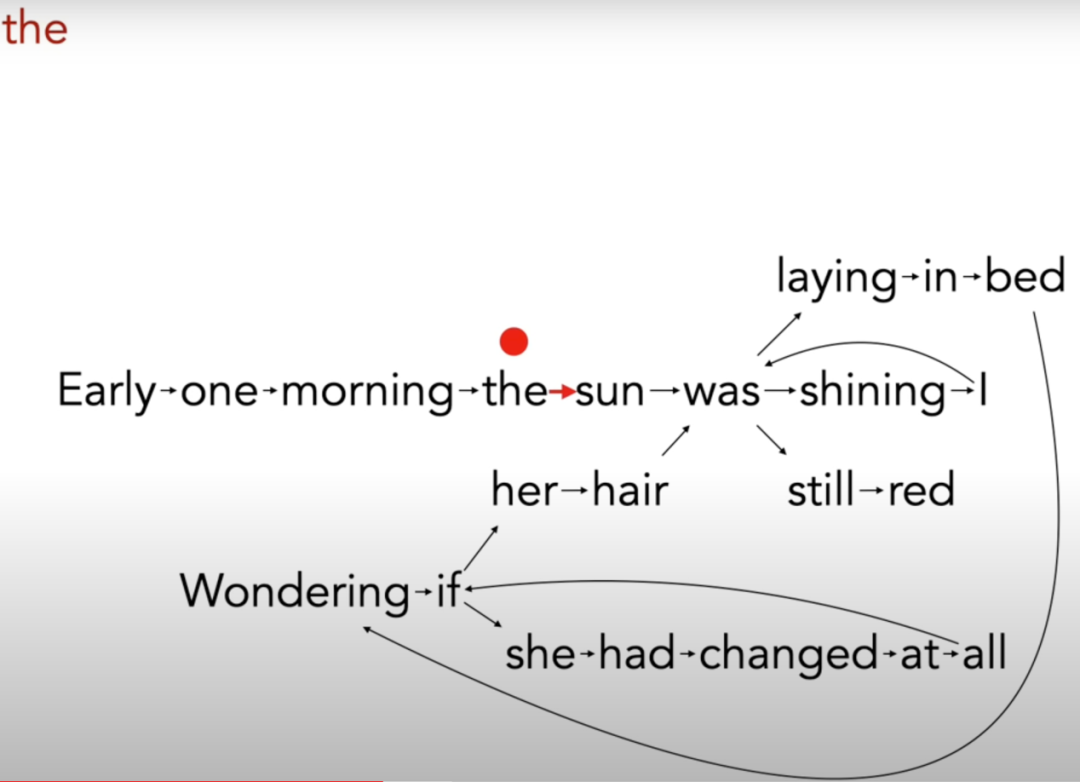

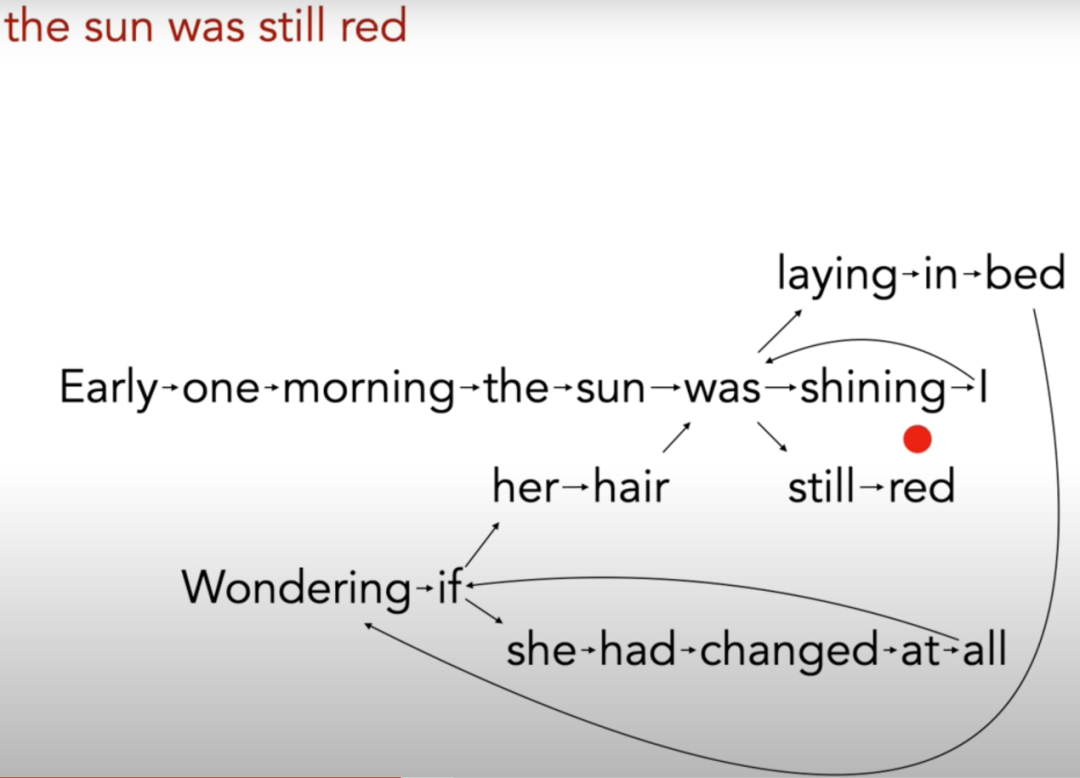

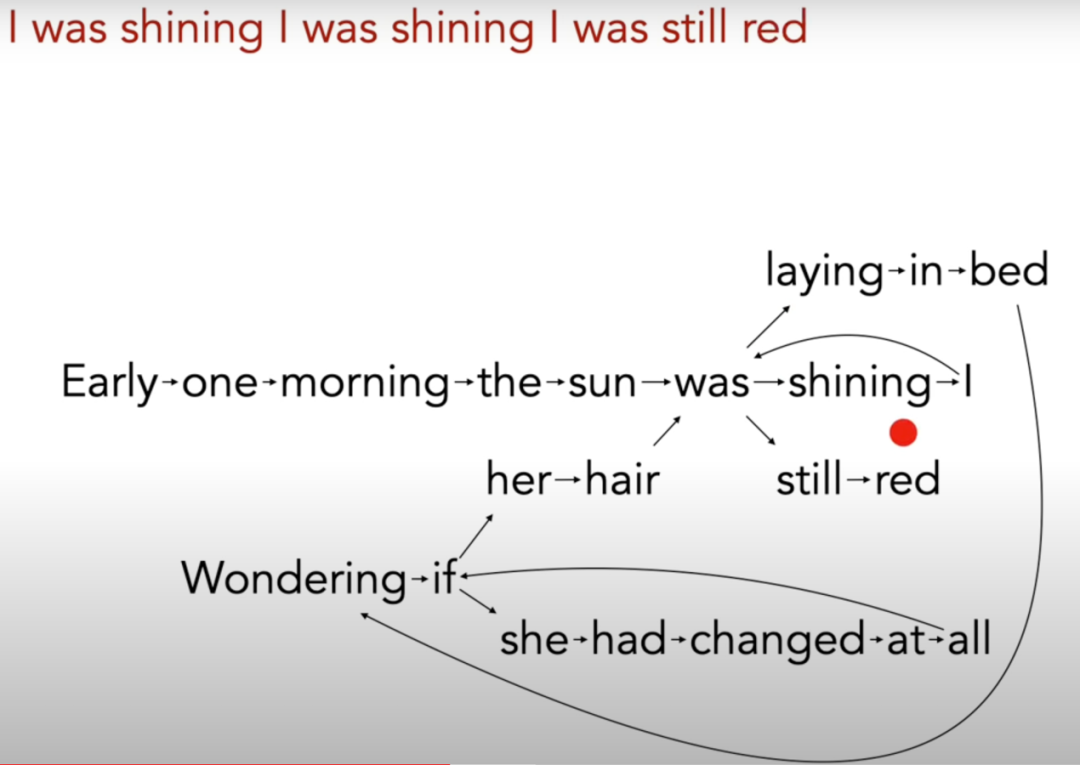

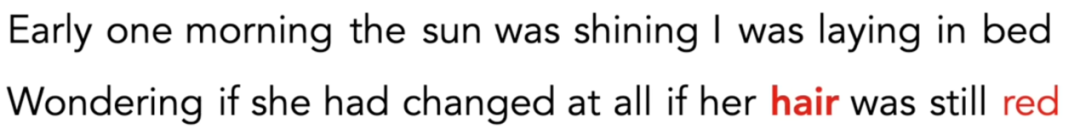

下面是一段来自诺贝尔奖得主鲍勃·迪伦的歌曲《Tangled Up In Blue》中的一段歌词,我们将以这段歌词为例,讨论大语言模型(LLM)生成内容的工作机理。

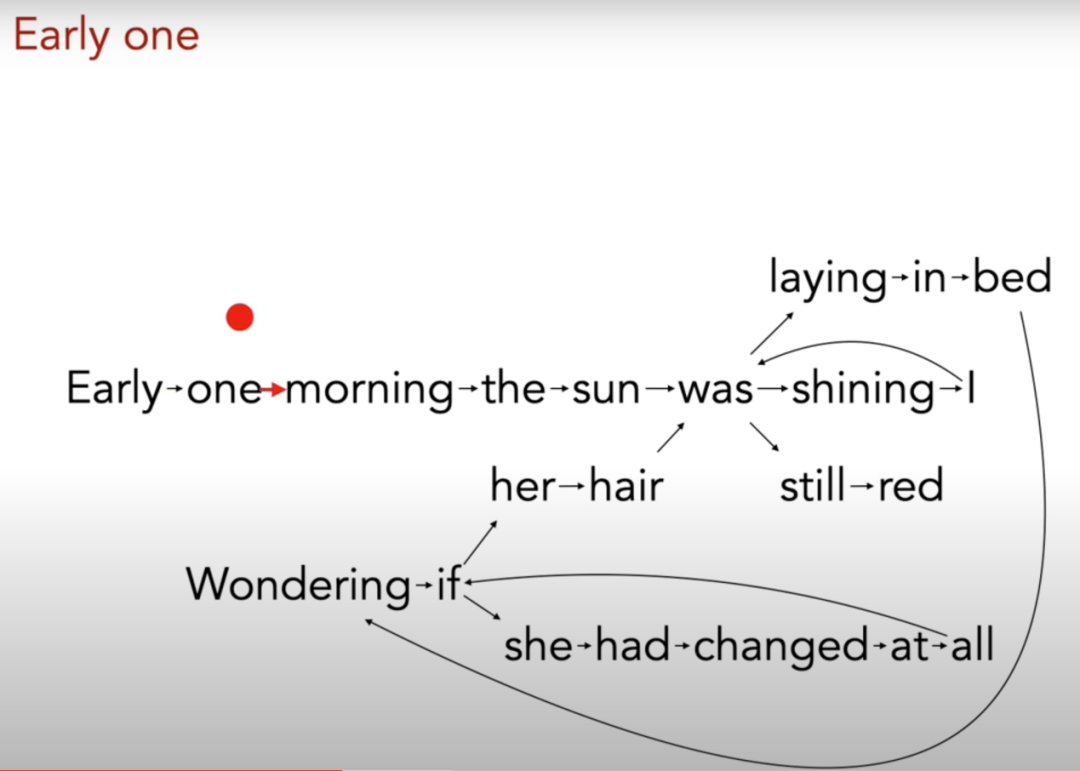

生成全新的词句

下面,我们尝试生成一个在歌曲中没有出现过的全新的短语。我们将从"the"开始,然后沿着图中的分支走。

简单模型的问题

通过上述方法构建了一个简单的语言模型,该模型也被称为马尔科夫模型。这种模型的基本思想是,给定当前的单词,下一个单词的概率只取决于当前的单词。这种模型非常有效,因为它可以生成新的、在原始数据中未出现过的句子,而且这些句子在语法和风格上往往都是合理的。

改进方案

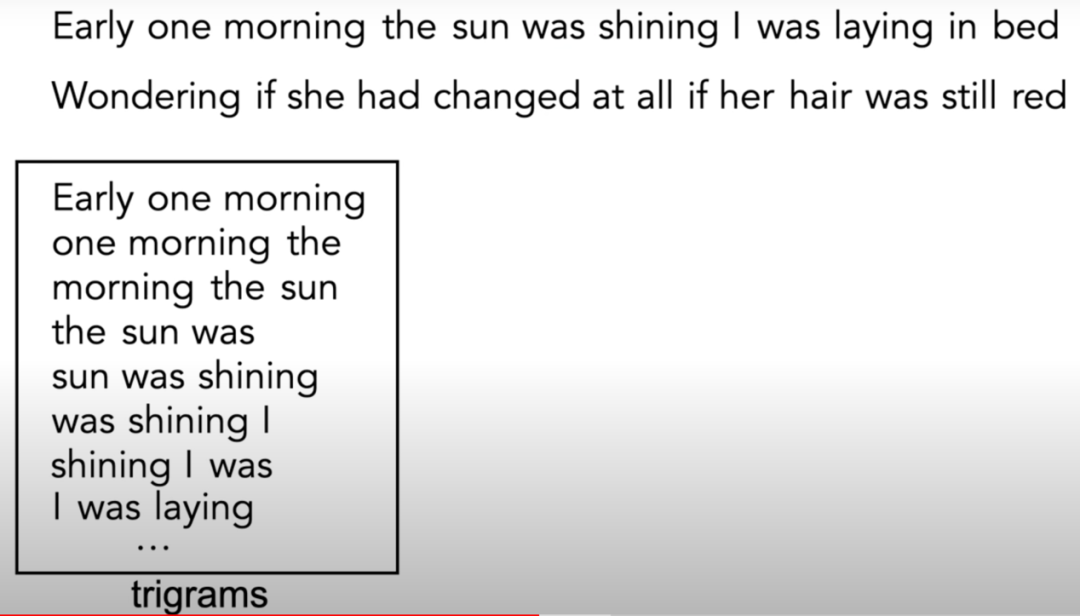

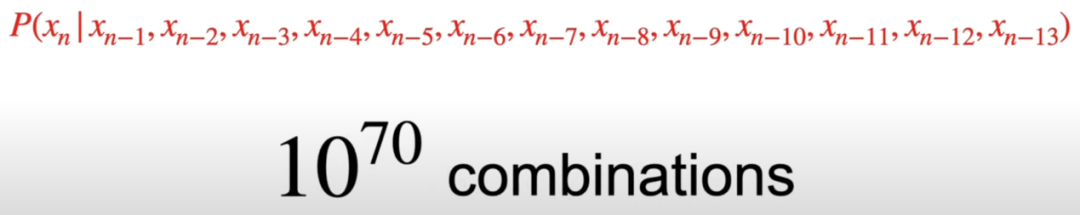

如何使我们的模型更加完善呢?首先,我们可以使用更多的文本来构建我们的模型。如果你使用整首歌来建立模型,结果可能会有所改善。但是,这些生成的句子还是有点奇怪。真正的问题在于,我们的模型过于简化。它假设每个单词仅取决于前一个单词。我们可以把这种关系写成条件概率的形式。

神经网络方法

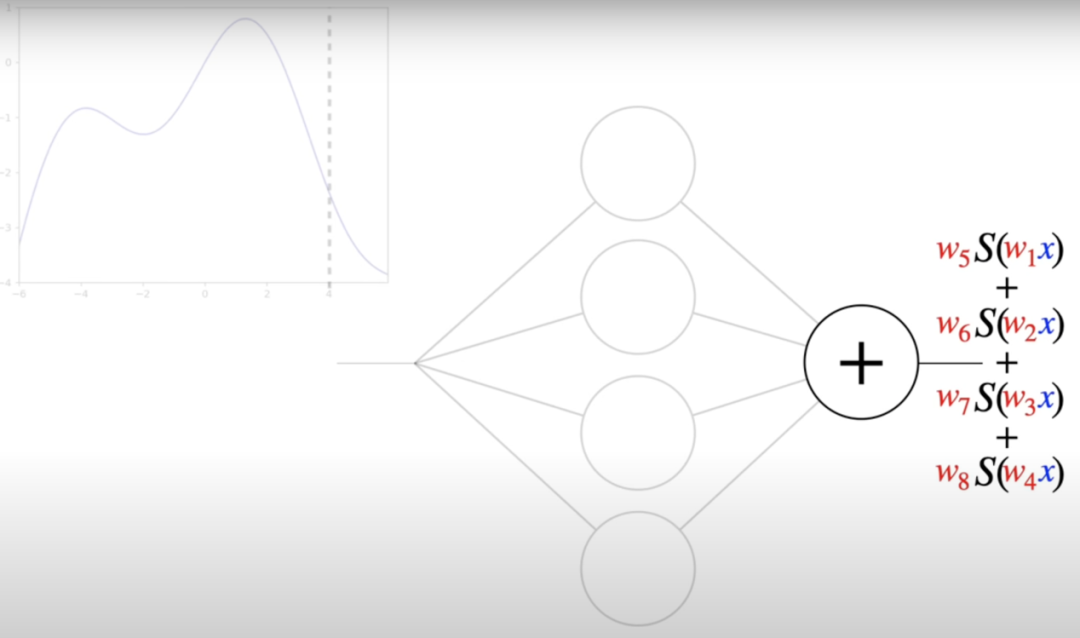

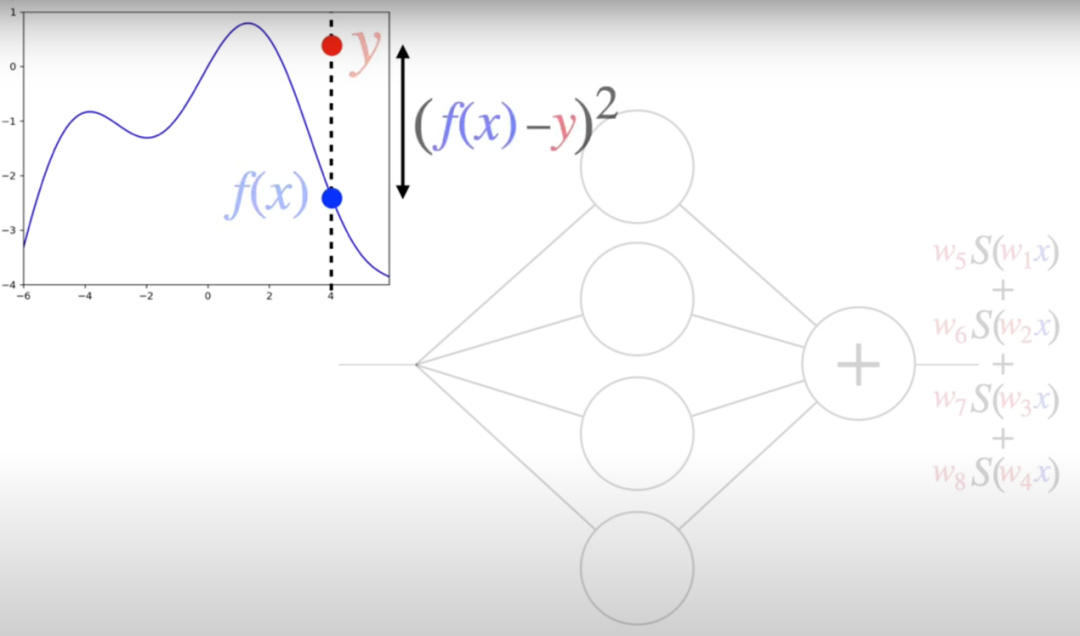

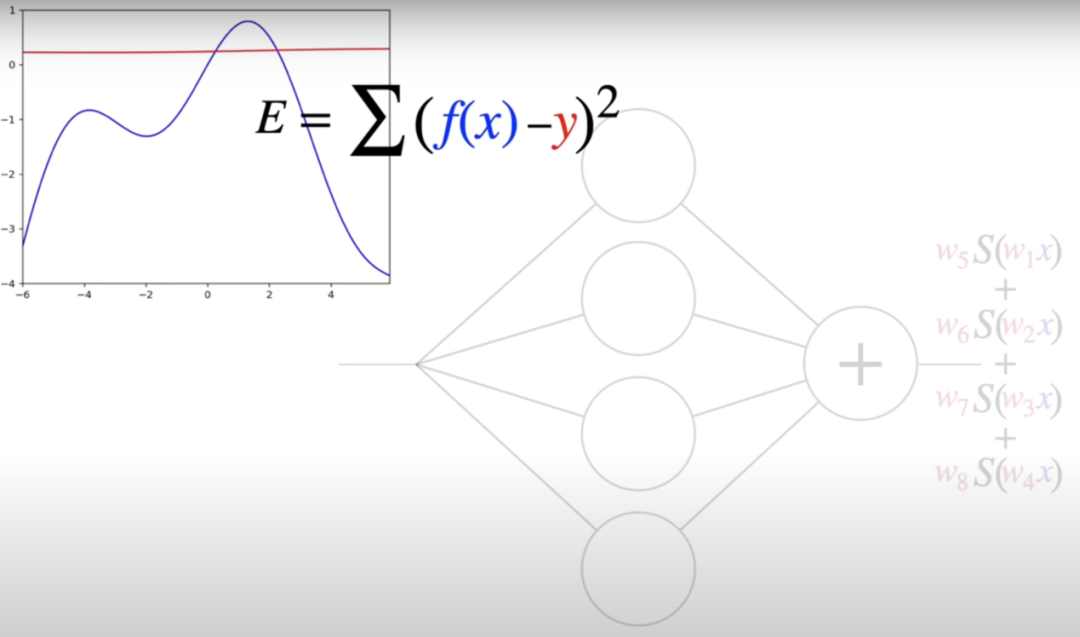

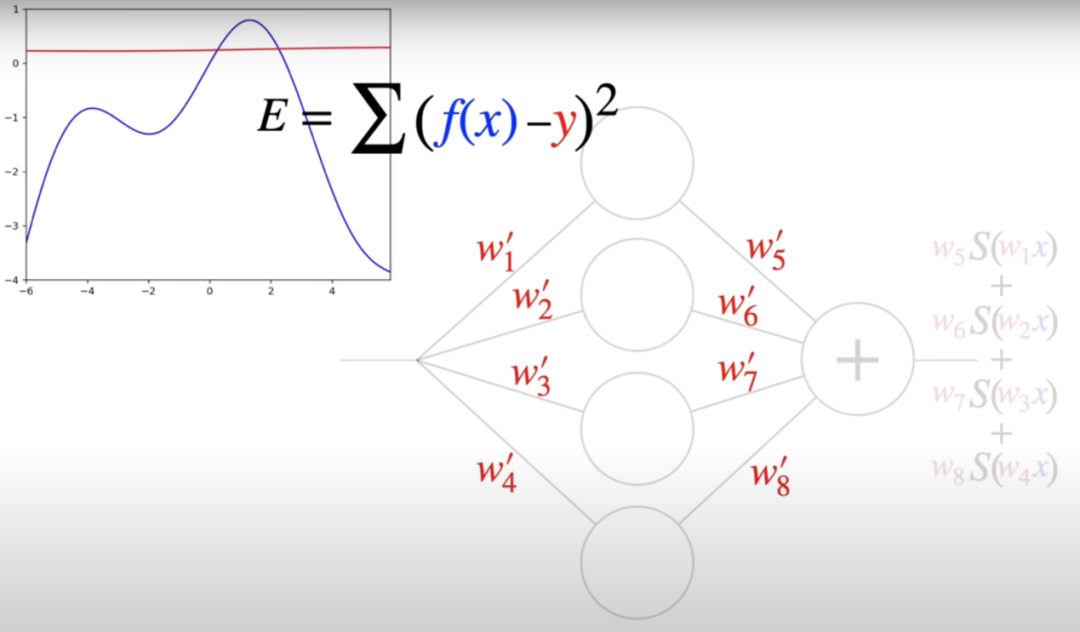

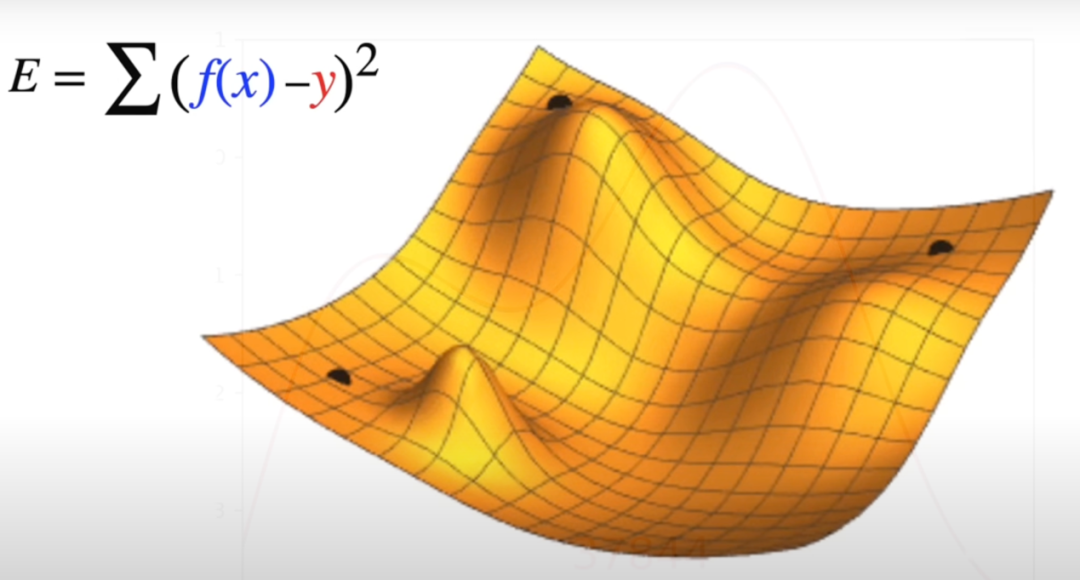

函数近似的方法

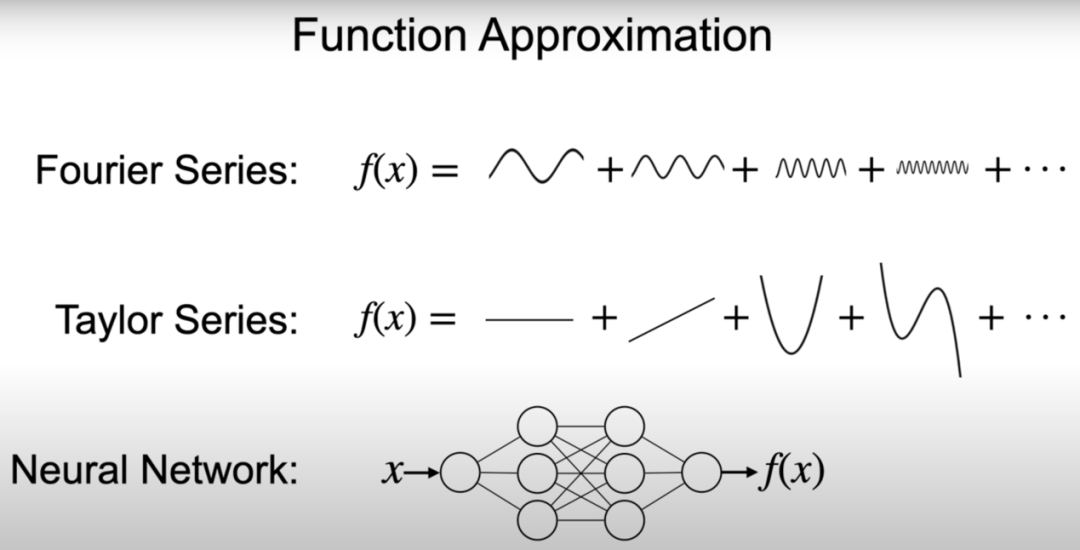

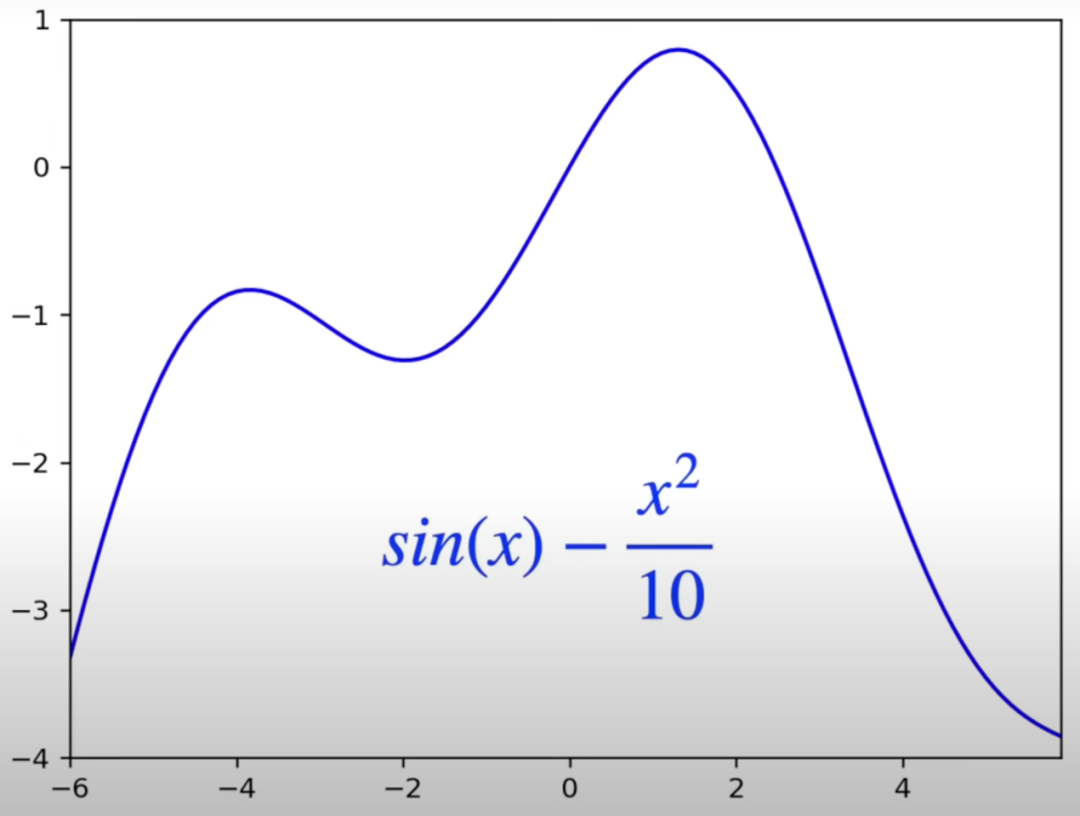

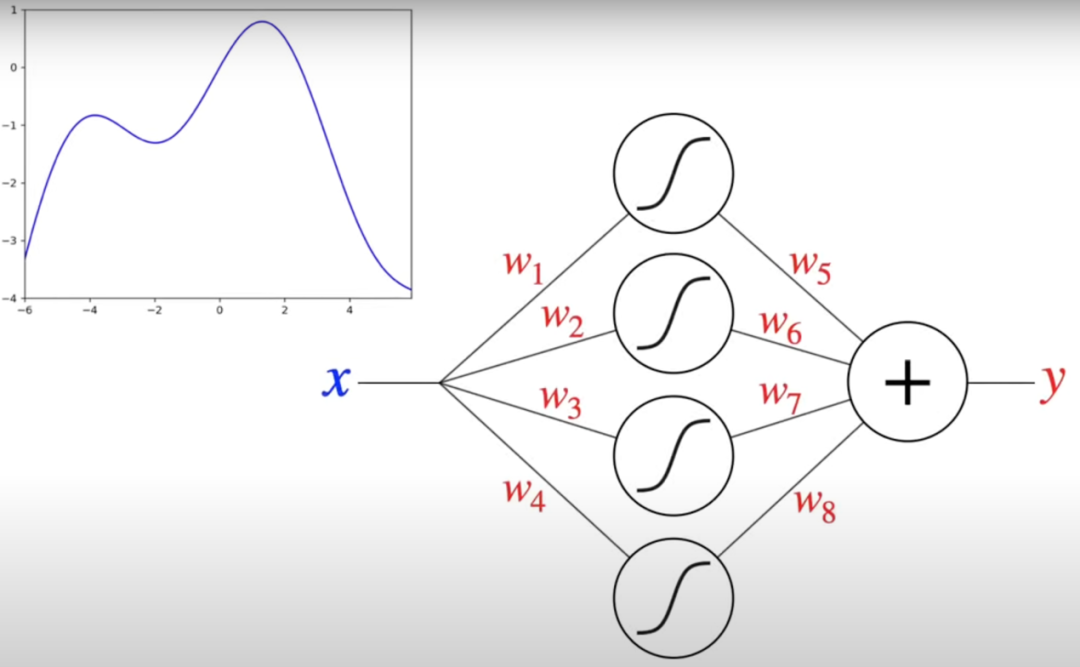

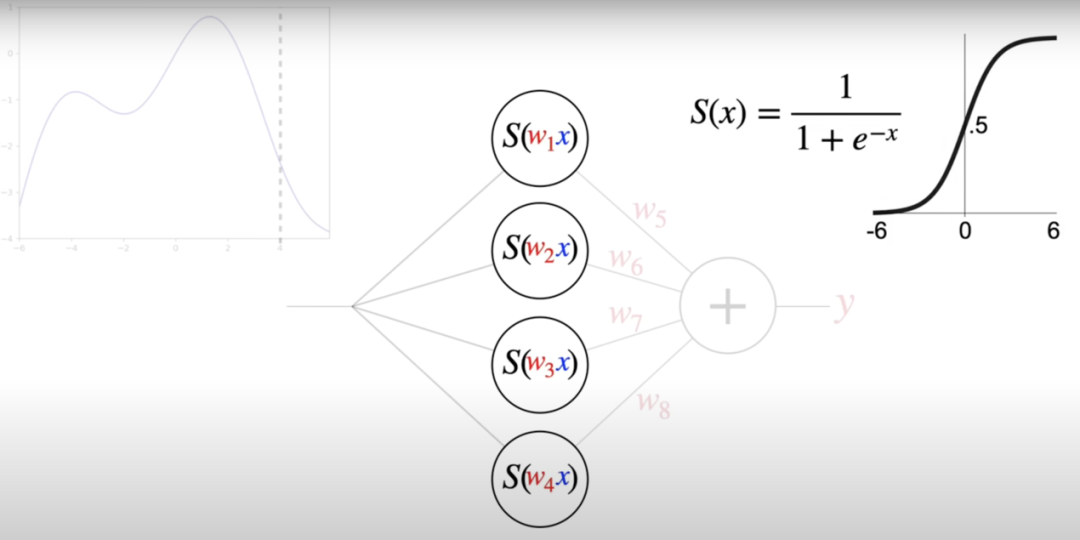

如前所述,为了精确对语言建模,需要引入更长或更复杂的条件概率函数。由于这些函数的复杂程度极高,我们无法对其进行精确模拟,不过,我们可以尝试对其进行近似。对某个函数的近似方法有许多,比如大家熟知的傅立叶级数,它通过正弦和余弦来近似一个函数,或者是泰勒级数,它由多项式的和组成。这两者都被认为是通用近似器,因为它们几乎能近似任何函数。

关联 · 阅读

读完该文,您是否对开头的热身问题有所答案?

报告推荐

推荐阅读

本文由「流媒体网」原创出品,