【AI新趋势期刊#2】AI发明计算机算法,如何给大模型排行,照片秒变...

前言

每天都要浏览大量AI相关新闻,是不是感到信息量爆炸,有效信息少?

这么多新产品和新工具,到底哪些是真正是有价值的,哪些只是浮躁的一时热点?

想参与AI产品和工具的开发,从哪里能够获得大量的灵感和思路?

我会把AI相关的新趋势、新想法、新思路,和成熟AI产品、工具、模型等整理在这里,帮助大家去除信息噪音,更高效的了解AI前沿发展。

主要围绕:

AI业界趋势、想法、思路

AI产品

AI开发者工具

AI模型

作为本期刊的第二期,我们主要围绕2023年5-6月发布的相关信息为主,观众朋友们请注意时效性。

想法/思路

大模型训练的材料会耗尽吗?

以下节选自阮一峰科技周刊中阮老师的个人思考,觉得蛮有意思。

现在的新闻报道,天天有 AI 的新闻,里面会提到很多模型。

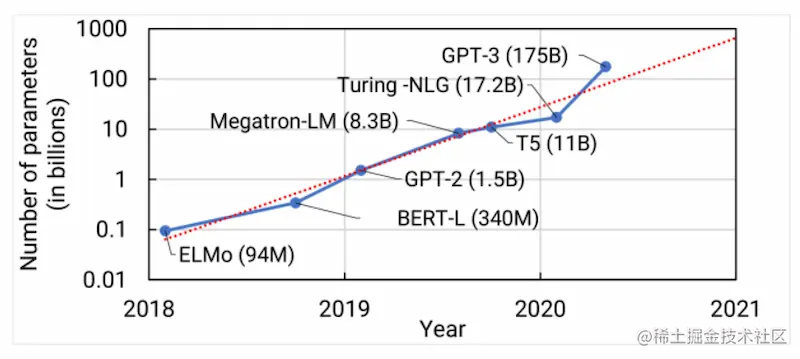

分辨模型的强弱,有一个关键指标,就是看它有多少个参数。一般来说,参数的数量越多,模型就越强。

GPT-2 有15亿个参数,GPT-3 和 ChatGPT 有1750亿个,GPT-4 没有公布这个指标,据传比上一代大5倍以上。

那么,什么是参数呢?按照我粗浅的理解,参数相当于模型预测时,所依据的神经网络的节点数量。参数越多,就代表了模型所考虑的各种可能性越多,计算量越大,效果越好。

既然参数越多越好,那么参数会无限增长吗?

答案是不会的,因为参数受到训练材料的制约。必需有足够的训练材料,才能计算出这些参数,如果参数无限增长,训练材料势必也要无限增长。

我看到的一种说法是,训练材料至少应该是参数的10倍。举例来说,一个区分猫照片和狗照片的模型,假定有1,000个参数,那么至少应该用10,000张图片来训练。

ChatGPT 有1750亿个参数,那么训练材料最好不少于17500亿个词元(token)。"词元"就是各种单词和符号,以小说《红楼梦》为例,它有788,451字,就算100万个词元。那么, ChatGPT 的训练材料相当于175万本《红楼梦》。

根据报道,ChatGPT 实际上用了 570 GB 的训练材料,来自维基百科、互联网图书馆、Reddit 论坛、推特等等。

大家想一想,更强大的模型需要更多的训练材料,问题是能找到这么多材料吗,会不会材料有一天不够用?

我告诉大家,真的有学者写过论文,研究这个问题。

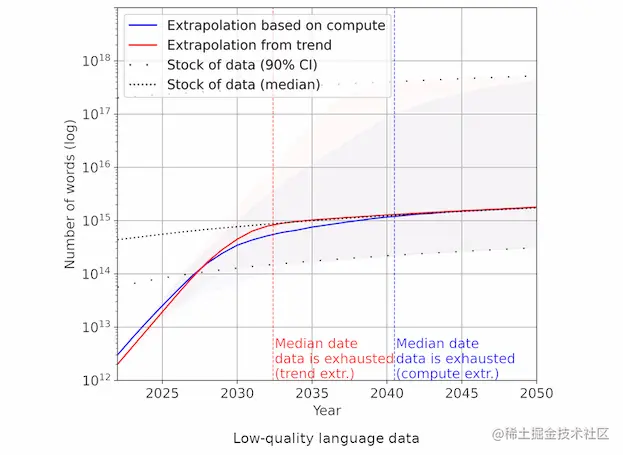

过去10年来,AI 训练数据集的增长速度远快于全世界的数据存量的增长速度。如果这种趋势继续下去,耗尽数据存量是不可避免的。

论文给出了三个时间点。

2026年:用完一般的语言数据

2030年~2050年:用完所有的语言数据

2030年~2060年:用完所有的视觉数据

也就是说,根据他们的预测,大概三四年后,新的训练材料就会很难找。最迟三十年后,全世界所有材料都不够 AI 的训练。

上图是作者给的趋势图,虚线是训练材料的增长速度,红线和蓝线是模型增长速度的不同预测。到了2035年以后,这三根线就合在一起了,曲线变得越来越平。作者认为,到了那时,由于没有足够的训练材料,AI 模型的发展速度可能就会显著放缓。如果他的预测是正确的,就意味着,跟大家想的不一样,AI 飞速发展不会持续很久。现在也许就是发展最快的阶段,然后就会开始放慢,等到本世纪中叶就会显著放慢,接近停滞,跟量子物理学的现状差不多。

下面的新闻也讨论了该问题,在这里节选片段。

https://m.thepaper.cn/newsDetail_forward_23467960

什么是模型崩溃?

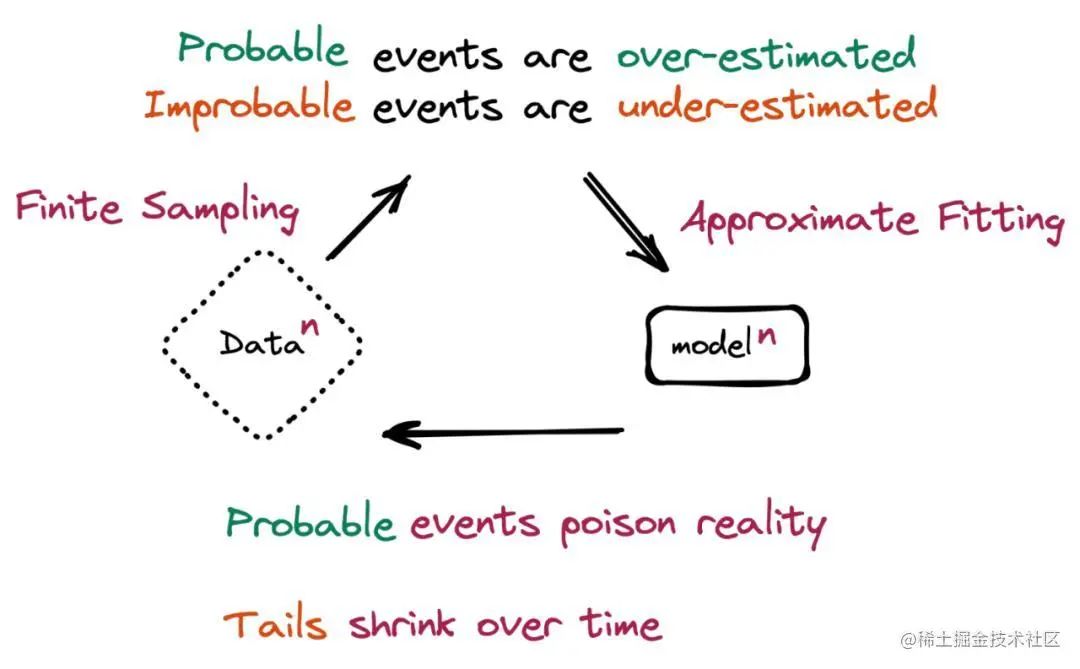

本质上,当 AI 大模型生成的数据最终污染了后续模型的训练集时,就会发生“模型崩溃”。

论文中写道,“模型崩溃指的是一个退化的学习过程,在这个过程中,随着时间的推移,模型开始遗忘不可能发生的事件,因为模型被它自己对现实的投射所毒化。”

一个假设的场景更有助于理解这一问题。机器学习(ML)模型在包含 100 只猫的图片的数据集上进行训练——其中 10 只猫的毛色为蓝色,90 只猫的毛色为黄色。该模型了解到黄猫更普遍,但也表示蓝猫比实际情况偏黄一点,当被要求生成新数据时,会返回一些代表“绿毛色的猫”的结果。随着时间的推移,蓝色毛色的初始特征会在连续的训练周期中逐渐消失,从逐渐变成绿色,最后变成黄色。这种渐进的扭曲和少数数据特征的最终丢失,就是“模型崩溃”。

笔者认为,虽然训练材料耗尽离我们现在还很遥远,不过如果训练所需要的材料一直以指数级增长,而我们现有的材料又没有跟上时,确实有可能会提前碰到这种瓶颈。

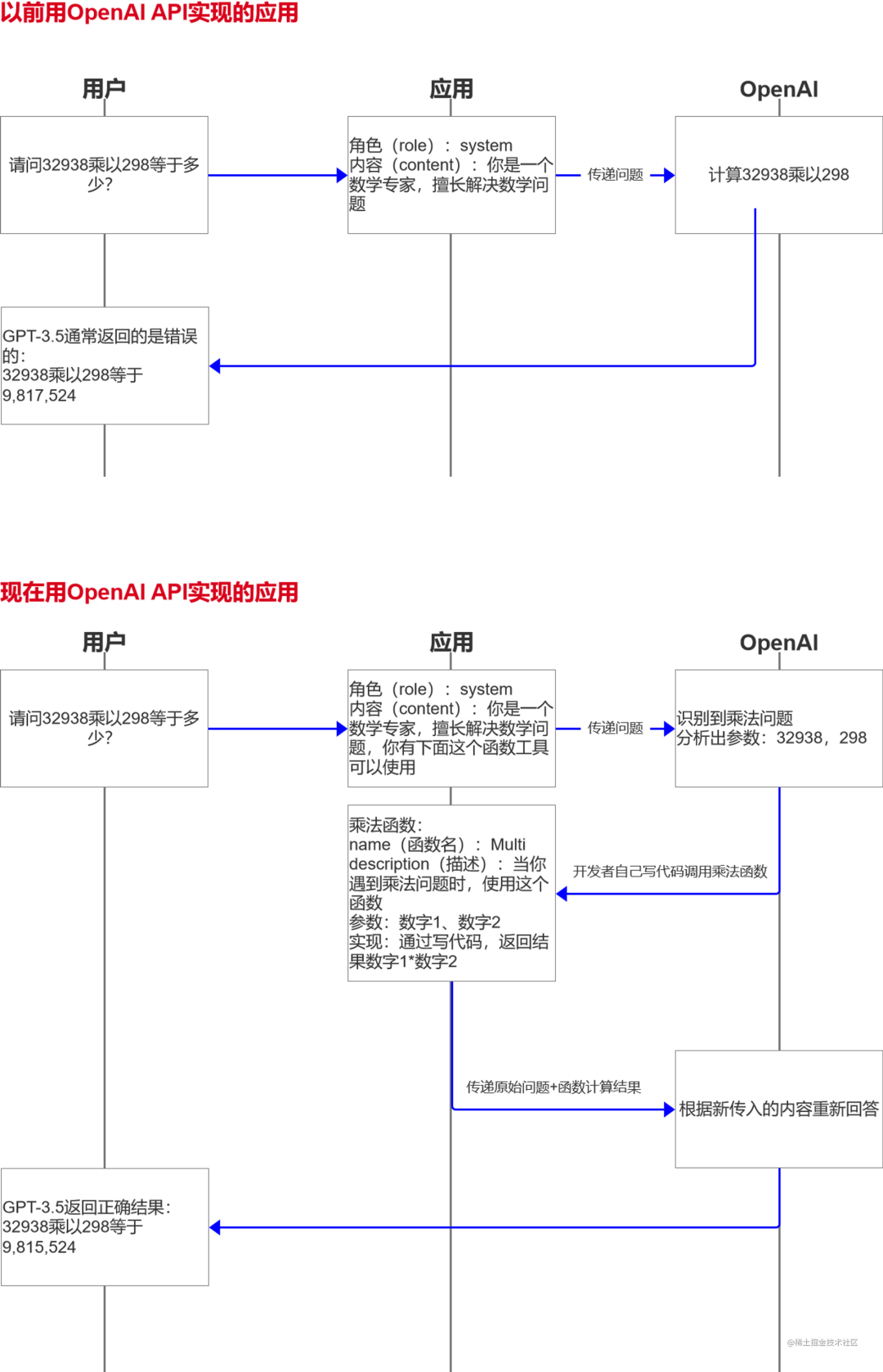

OpenAI支持函数调用功能

关于OpenAI的函数调用功能,一个比喻:以前让OpenAI回答数学题,只能靠催眠(你是数学专家),然后回答,常常答错;现在让OpenAI回答数学题,同时给他一个计算器(他知道什么时候该用计算器,但是他自己不会用),当他识别出这是数学题时,会把数字吐给你,你自己再用计算器算结果,再把结果和问题扔给他做回答。这也是很多其他新模型会附带的功能,类似模型插件。

优点:准确又智能。结果是你自己的函数计算的,肯定错不了;

快速整理播客笔记

阿里的通义听悟可以快速整理音频的内容,转化为文字。

我们首先需要下载播客音频,将音频导入通义听悟平台,1 个小时的音频大概只需要 5 分钟导入和处理;

通义听悟处理后,自动生成章节和声音转录的文本(能够区分不同说话人),支持文本翻译成中文;

随后可以根据自动生成的章节或关键词快速跳转收听感兴趣的内容,不感兴趣的一律跳过;随时在右侧做笔记;

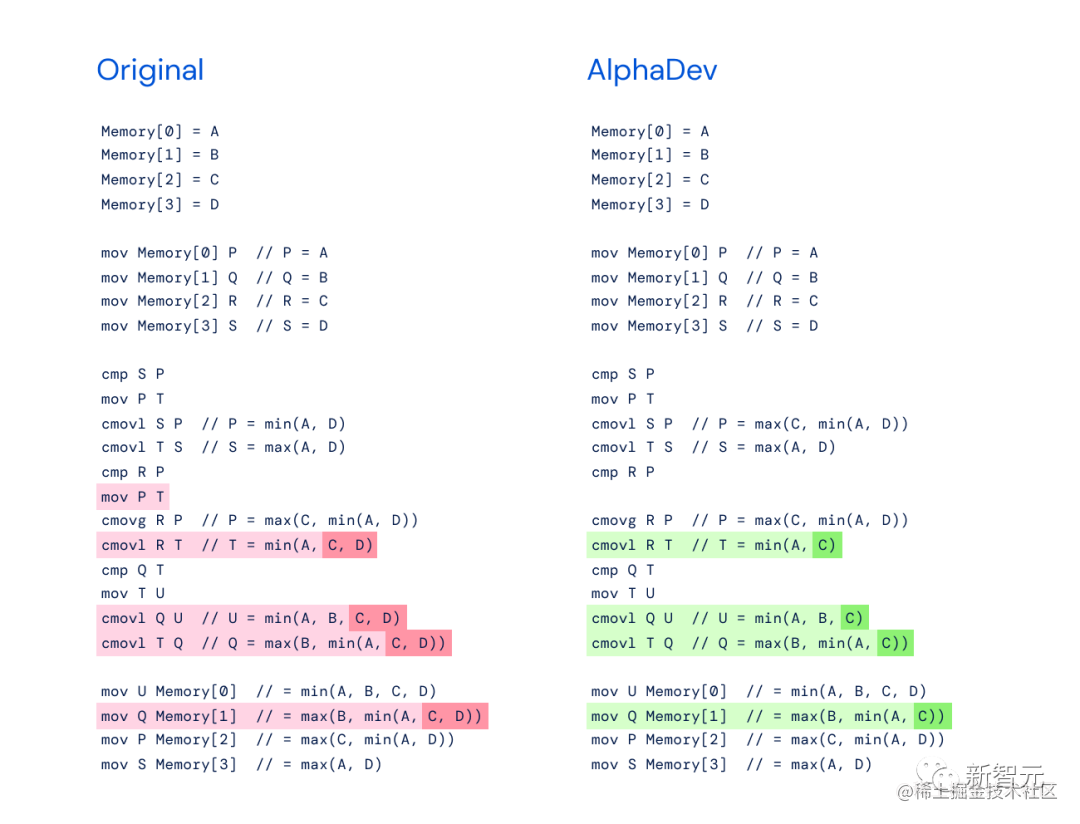

AI发明计算机算法

https://www.ithome.com/0/698/425.htm

谷歌人工智能部门 DeepMind 宣布,使用 AI 发现了一种新的算法 AlphaDev,把排序速度提高了 70%,细节可以看原文。

模型

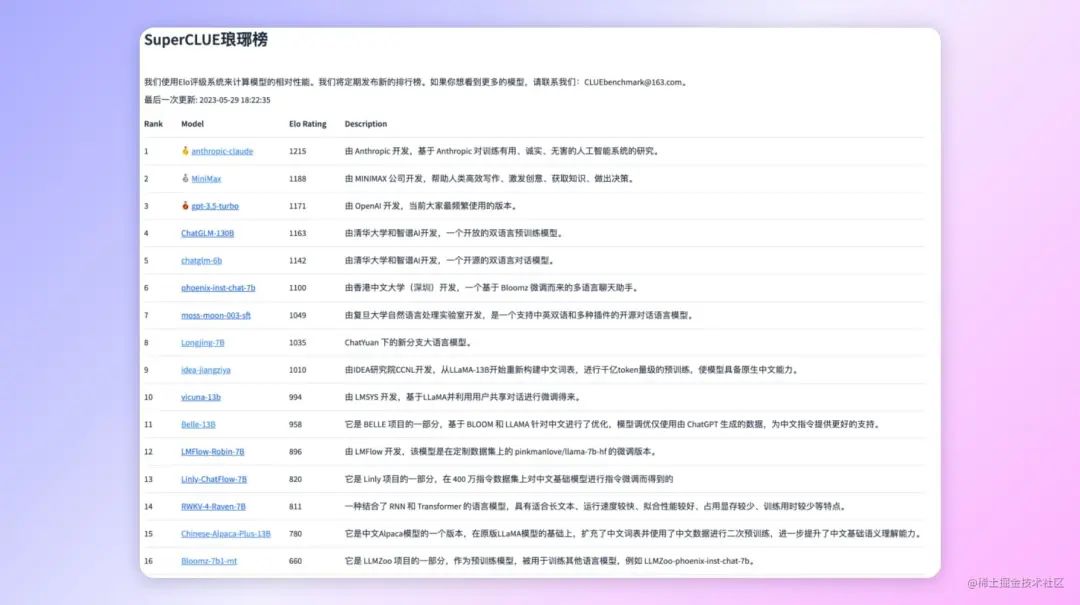

如何给大模型排行?

随着大模型研究的流行,非常多模型在市面上大乱斗,也有非常多的模型排行榜。我们该如何科学的对模型进行排名呢?

在模型硬指标上,有以下几个方面需要对比:

模型大小

训练数据集

训练和推理效率

应用领域(单模态/多模态等)

...

除开硬指标,我在网上了解了一下,目前针对LLM公认的权威排行机构和论文还比较少,比较知名的有LMSYS

https://chat.lmsys.org/

Large Model Systems Organization(LMSYS ORG)是由UC Berkeley与UCSD和CMU合作的学生和教职员工创立的开放研究组织。我们的目标是通过共同开发开放数据集,模型,系统和评估工具来使每个人都可以访问大型模型。我们的工作包括机器学习和系统中的研究。我们培训大型语言模型并使其广泛使用,同时还开发了分布式系统以加速其培训和推理。

国内有一个CLUE排行榜,不过我看了下,感觉有点模仿国外的模型评测GLUE和SuperGLUE的感觉,大家可以参考,但是具体认可度有待观察。

https://github.com/CLUEbenchmark/SuperCLUELYB

文字转音频 Bark

https://github.com/suno-ai/bark

Bark 是由 Suno 创建的基于转换器的文本到音频模型。Bark 可以生成高度逼真的多语言语音以及其他音频 - 包括音乐、背景噪音和简单的音效。该模型还可以产生非语言交流,如大笑、叹息和哭泣。截至6月20号Github已经20k Star。

简单来说,你可以写一段文本,并选择一种语调,给机器朗读。但与此同时,支持:

除了英语外,还支持他国语言

支持一些非文字的声音,比如清嗓子、大笑、哼哼等

通过加上音乐符号♪,让他用唱歌的形式朗读。

可以给他输入音频,他会输出模仿声调

....(还有很多能力)

支持的语言:

| Language | Status |

|---|---|

| English (en) | ✅ |

| German (de) | ✅ |

| Spanish (es) | ✅ |

| French (fr) | ✅ |

| Hindi (hi) | ✅ |

| Italian (it) | ✅ |

| Japanese (ja) | ✅ |

| Korean (ko) | ✅ |

| Polish (pl) | ✅ |

| Portuguese (pt) | ✅ |

| Russian (ru) | ✅ |

| Turkish (tr) | ✅ |

| Chinese, simplified (zh) | ✅ |

我个人在HuggingFace试用了一下,真的很牛,不过一开始随便试用时候稍有不慎会出现很奇怪的合成音,听起来蛮恐怖。就和使用Stable Diffusion时画出了非人类的头一样...

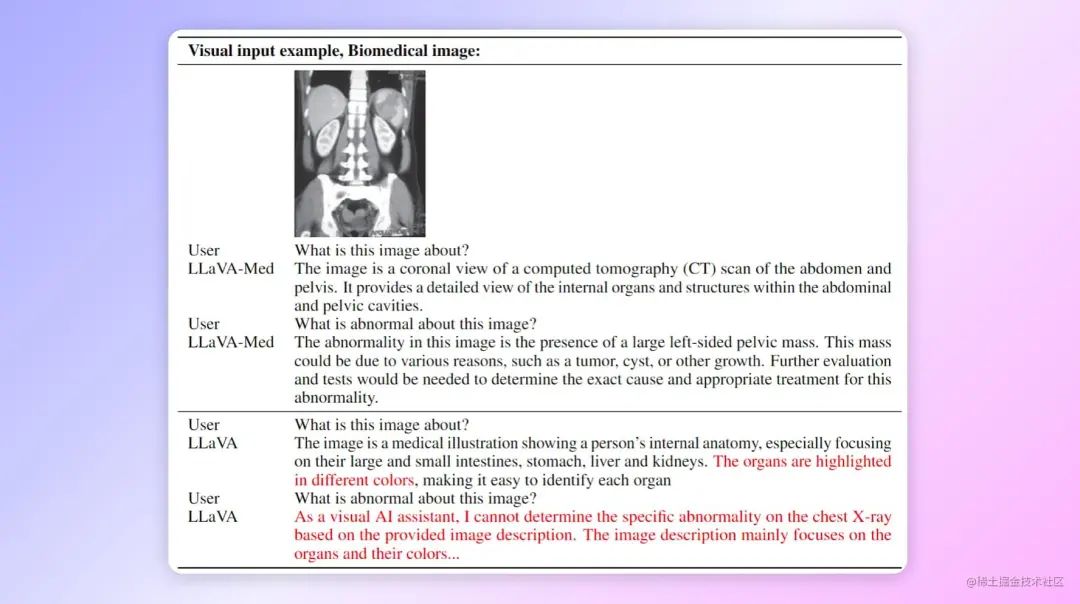

生物医学领域大模型

LLaVA-Med:面向生物医学领域的大语言模型和视觉模型

微软发布了LLaVA-Med,要做医药领域的GPT-4,支持多模态。可以识别X光片的信息。

Github:https://github.com/microsoft/LLaVA-Med

北京智源研究院LLM Aquila-7B

Aquila-7B:北京智源研究院开放的国产可商用的LLM

支持中英双语知识、支持商用许可协议、符合国内数据合规要求。后续还会发布33B模型。

Github:https://github.com/FlagAI-Open/FlagAI/tree/master/examples/Aquila

智源研究院和智谱AI同源,后者目前掌握了GLM系列。目前看后续前者更主要做学术研究,后者主要做商业化。

Aquila语言大模型在技术上继承了GPT-3、LLaMA等的架构设计优点,Aquila语言大模型是在中英文高质量语料基础上从0开始训练的,通过数据质量的控制、多种训练的优化方法,实现在更小的数据集、更短的训练时间,获得比其它开源模型更优的性能。也是首个支持中英双语知识、支持商用许可协议、符合国内数据合规需要的大规模开源语言模型。

Aquila-7B和Aquila-33B开源模型使用 智源Aquila系列模型许可协议, 原始代码基于Apache Licence 2.0。

王小川 百川LLM

王小川组建的「百川智能」正式推出首个70亿参数中英文LLM——baichuan-7B。国产、开源、免费、可商用。

Github:https://github.com/baichuan-inc/baichuan-7B

产品

金融GPT:FinGPT

https://github.com/AI4Finance-Foundation/FinGPT

作者使用中国金融市场数据和美国金融市场数据,分别用ChatGLM和LLaMA模型,配合Lora训练,做出了FinGPT

能够实现如下应用:

智能投顾

ChatGPT可以像专业人士一样进行投资建议。

在这个例子中,苹果的股价上涨与ChatGPT分析新闻的预测相符。

量化交易

我们还可以使用新闻、社交媒体推文或者公司公告来构建情感因子,右侧的部分是由Twitter推文和ChatGPT信号产生的交易结果,数据来自于一个称为stocknet-dataset的数据集。

正如您从图片中所看到的,由ChatGPT生成的交易信号非常出色,我们甚至可以仅通过根据Twitter情感因子交易而获得良好的结果。

因此,我们可以通过结合价格因素来获得更好的结果。

低代码开发

我们可以使用LLMs的帮助来编写代码。

右侧显示了我们如何快速高效地开发我们的因子和其他代码。

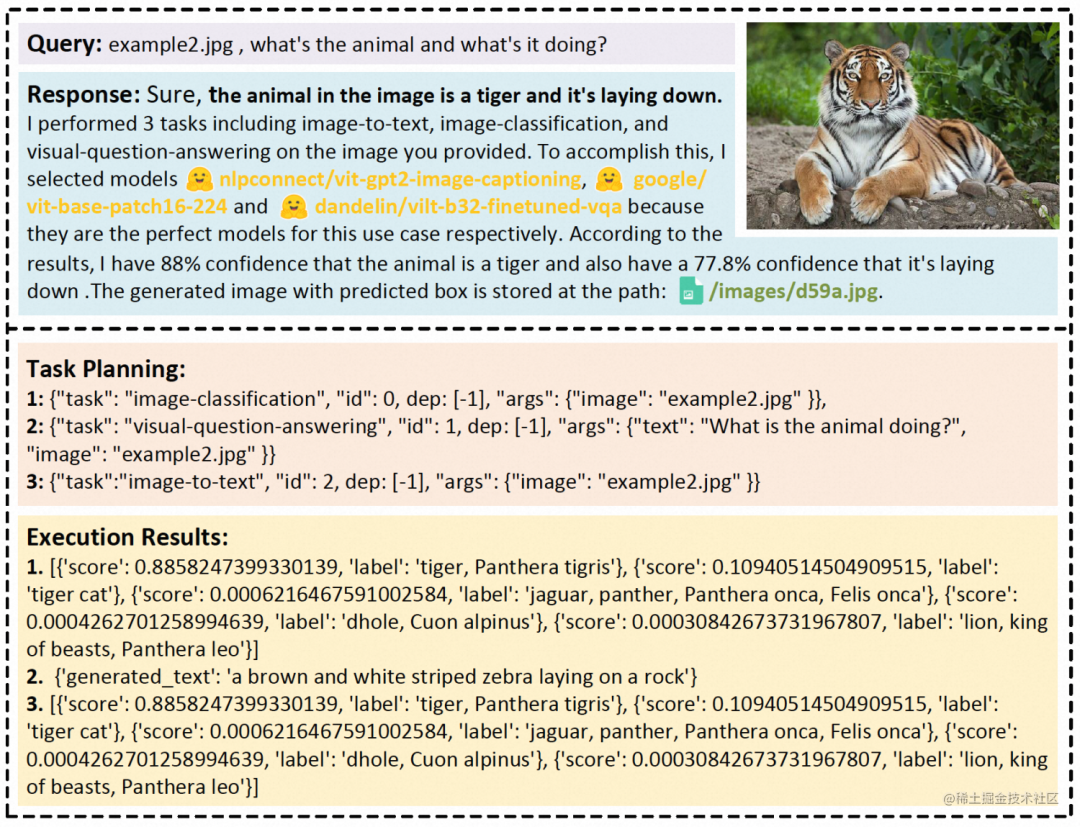

微软HuggingGPT

https://huggingface.co/spaces/microsoft/HuggingGPT

解决不同领域和模态的AI任务是迈向人工智能的关键一步。虽然现在有大量的AI模型可以用于解决不同的领域和模态的问题,但是它们不能解决复杂的AI问题。由于大模型(LLM)在语言理解、生成、交互和推理上展现出很强的能力,所以作者认为LLM可以充当一个控制器的作用来管理现有的AI模型以解决复杂的AI任务,并且语言可以成为一个通用的接口来启动AI处理这些任务。基于这个想法,作者提出HuggingGPT,一个框架用于连接不同的AI模型来解决AI任务。

具体的步骤是:

任务规划:使用ChatGPT来获取用户请求

模型选择:根据Hugging Face中的函数描述选择模型,并用选中的模型执行AI任务

任务执行:使用第2步选择的模型执行的任务,总结成回答返回给ChatGPT

回答生成:使用ChatGPT融合所有模型的推理,生成回答返回给用户

通过ChatGPT的强语言能力和Hugging Face丰富的模型库,HuggingGPT可以解决大部分复杂的AI任务,为走向真正的人工智能奠定基石。

AI知识库

https://albus.org/

我自己试了试,有一个很好的思路。当大家写文章,或者做视频没灵感时,可以现在心里想一个主题,让AIbus开始发散思维,进行简单的头脑风暴。

你可以给他设定文字基调:

可以设定文案的阅读受众,生成对应理解力的语句:

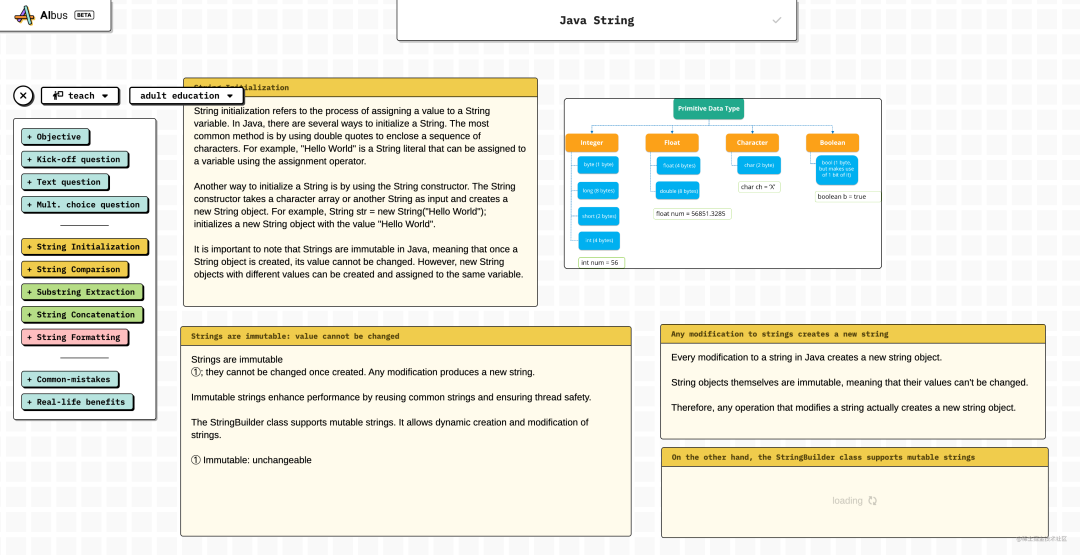

假设我要写一篇关于Java String字符串的介绍的博客,我以Java String为关键词,下图是他为我一步步生成的文案,并且配图也是生成的。

我现在越来越觉得写技术博客越来越是个伪命题,尤其是基础知识相关的博客,就算写出来了也是给AI大模型输送营养。

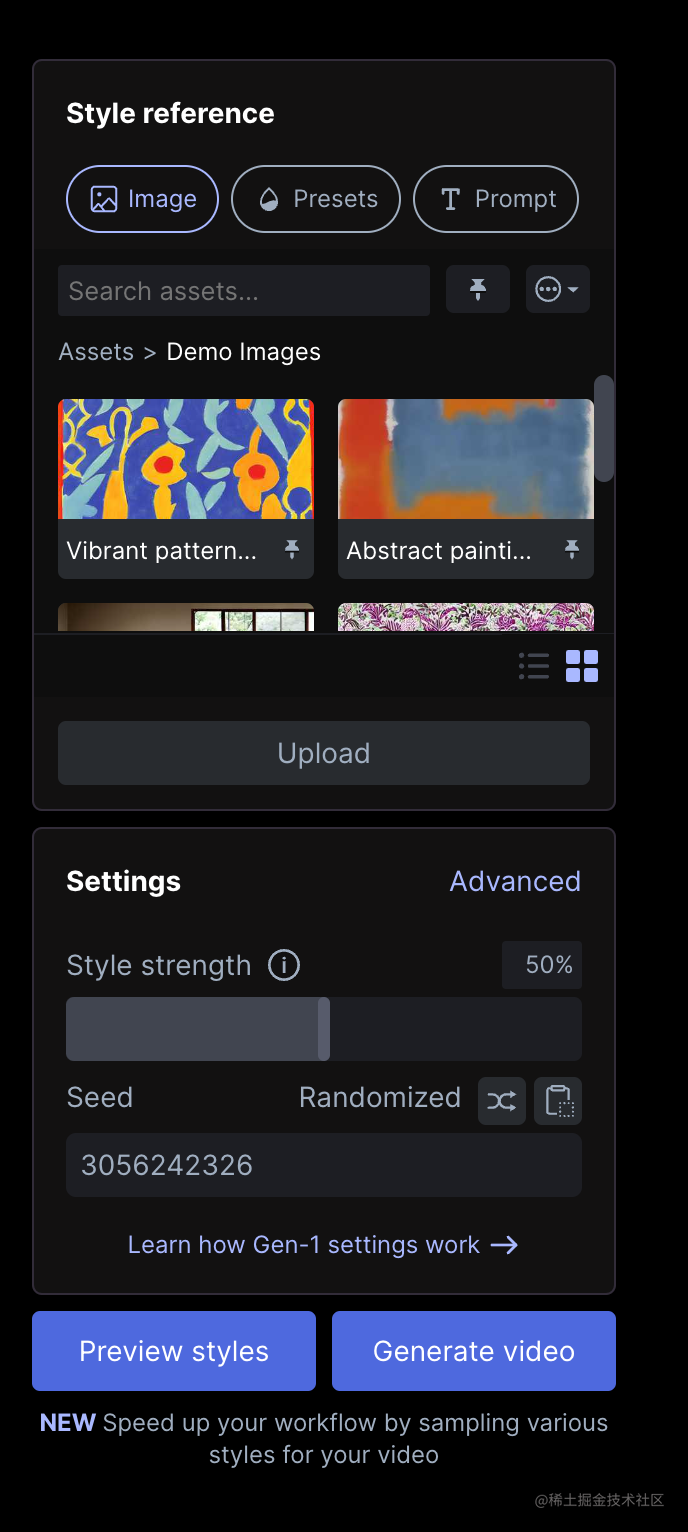

AI视频换风格

给它一个原始视频,然后选择一种想要的风格,AI帮你自动生成新的风格视频。

我自己也用官方Demo视频试了试,它可以支持在生成后视频的基础上再次微调参数,修改提示词,进行迭代。我生成的效果不是特别理想,应该还需要调整。

工具

Vercel 推出AI SDK

Vercel 是知名的云开发服务商,这次它内置了与OpenAI、LangChain和Hugging Face Inference的协作模块,目的是让开发者专注于产品研发,而不是基础设施搭建。一个预想不一定对:以后做web AI产品,用Vercel和OpenAI就够了。

https://vercel.com/blog/introducing-the-vercel-ai-sdk

通过SD将二维码变成图像

这个网站教你如何使用 Stable Diffusion,将二维码变成一幅图像。

我觉得这个很有意义,很多地方商家张贴各种二维码真的很丑,如果能够植入商家的宣传图片,比如美食,产品,人像,是真的有用,可以商业化。

https://stable-diffusion-art.com/qr-code/

参考

参考Meta360创新学院-AGI前夜

https://docs.meta360.vip

Github Trending

https://github.com/trending

往期精彩文章:

谁能真正替代你?AI编码工具深度对比 (chatGPT/Copilot/Cursor/New Bing)

- END -