【99期】中高级开发面试必问的Redis,看这篇就够了!

阅读本文大概需要 12 分钟。

来自:https://github.com/CyC2018/CS-Notes

一、概述

二、数据类型

STRING

LIST

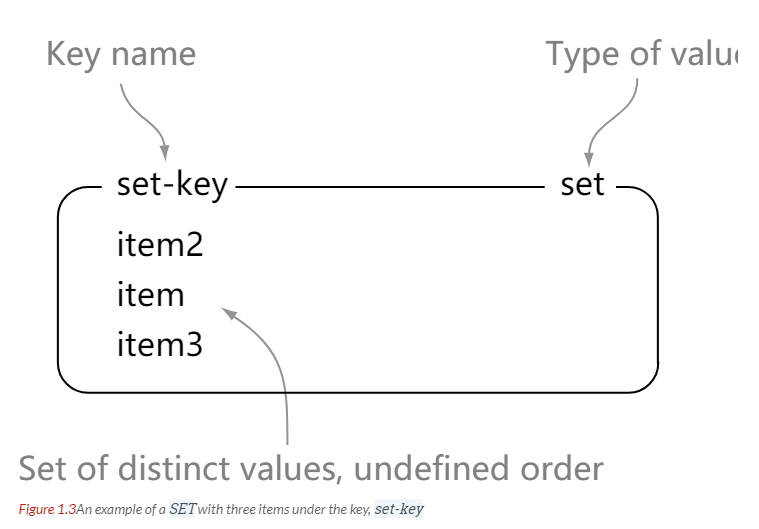

SET

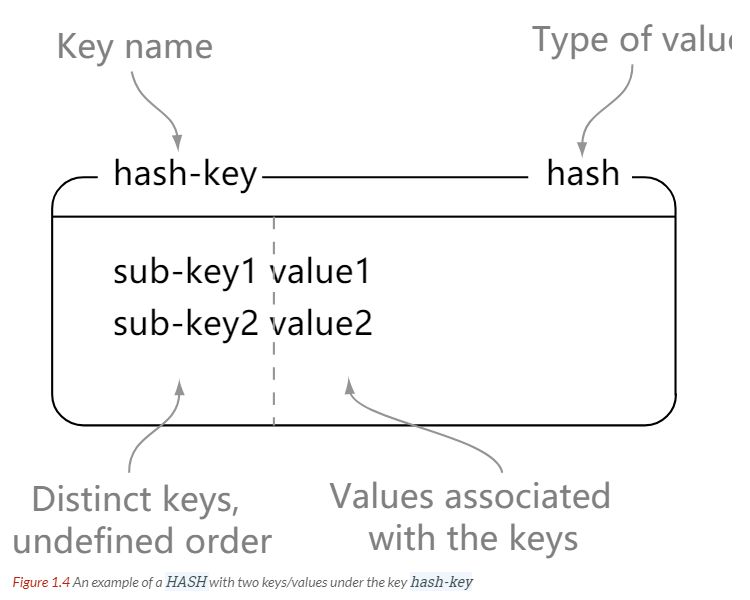

HASH

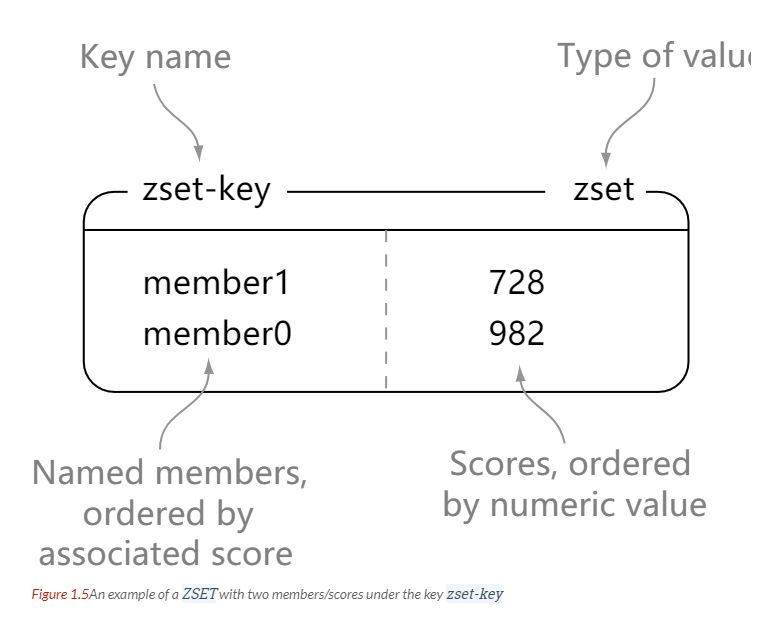

ZSET

三、数据结构

字典

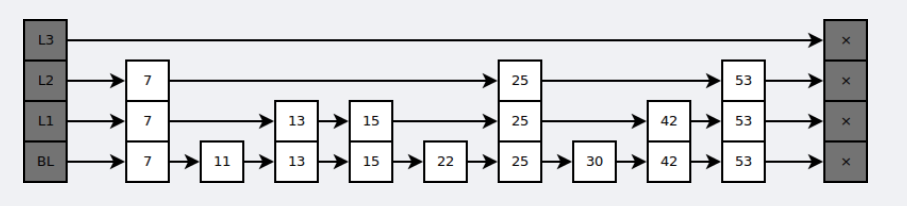

跳跃表

四、使用场景

计数器

缓存

查找表

消息队列

会话缓存

分布式锁实现

其它

五、Redis 与 Memcached

数据类型

数据持久化

分布式

内存管理机制

六、键的过期时间

七、数据淘汰策略

八、持久化

RDB 持久化

AOF 持久化

九、事务

十、事件

文件事件

时间事件

事件的调度与执行

十一、复制

连接过程

主从链

十二、Sentinel

十三、分片

十四、一个简单的论坛系统分析

文章信息

点赞功能

对文章进行排序

参考资料

一、概述

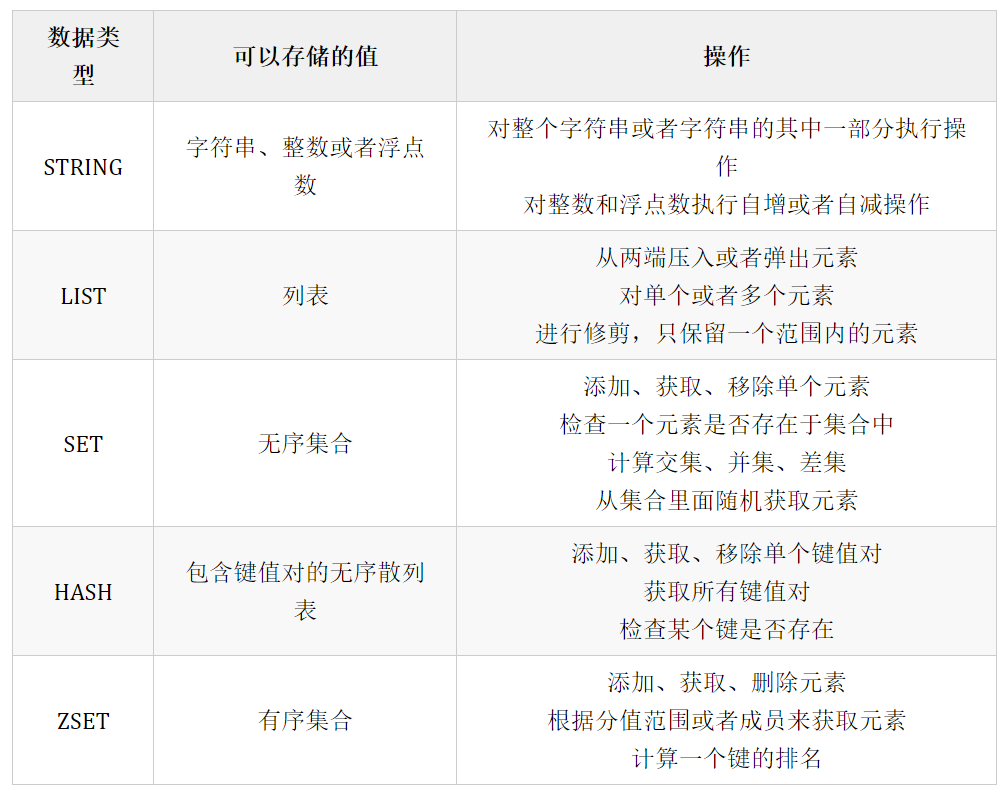

二、数据类型

What Redis data structures look like

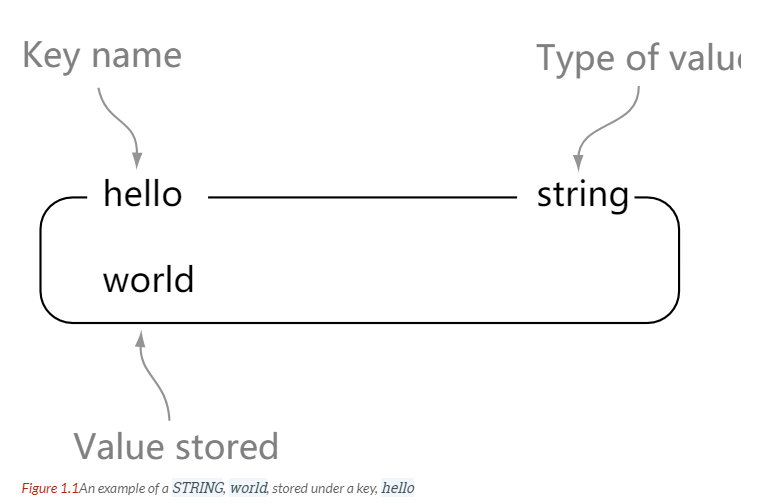

STRING

> set hello world

OK

> get hello

"world"

> del hello

(integer) 1

> get hello

(nil)

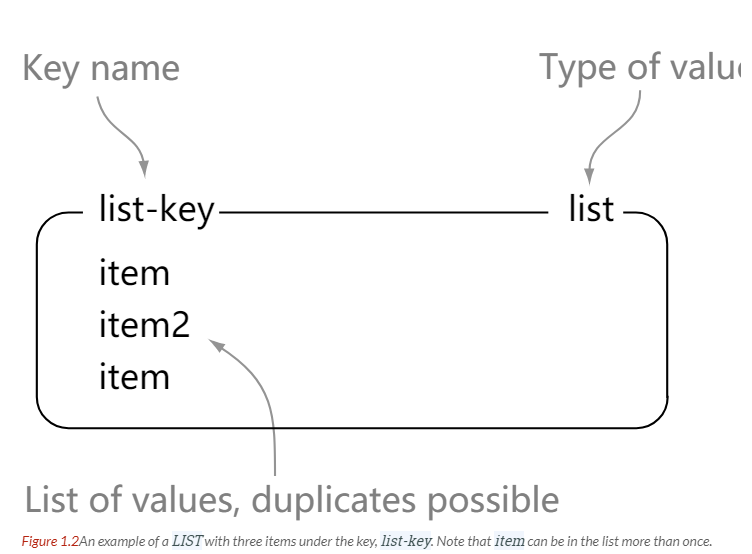

LIST

> rpush list-key item

(integer) 1

> rpush list-key item2

(integer) 2

> rpush list-key item

(integer) 3

> lrange list-key 0 -1

1) "item"

2) "item2"

3) "item"

> lindex list-key 1

"item2"

> lpop list-key

"item"

> lrange list-key 0 -1

1) "item2"

2) "item"

SET

> sadd set-key item

(integer) 1

> sadd set-key item2

(integer) 1

> sadd set-key item3

(integer) 1

> sadd set-key item

(integer) 0

> smembers set-key

1) "item"

2) "item2"

3) "item3"

> sismember set-key item4

(integer) 0

> sismember set-key item

(integer) 1

> srem set-key item2

(integer) 1

> srem set-key item2

(integer) 0

> smembers set-key

1) "item"

2) "item3"

HASH

> hset hash-key sub-key1 value1

(integer) 1

> hset hash-key sub-key2 value2

(integer) 1

> hset hash-key sub-key1 value1

(integer) 0

> hgetall hash-key

1) "sub-key1"

2) "value1"

3) "sub-key2"

4) "value2"

> hdel hash-key sub-key2

(integer) 1

> hdel hash-key sub-key2

(integer) 0

> hget hash-key sub-key1

"value1"

> hgetall hash-key

1) "sub-key1"

2) "value1"

ZSET

> zadd zset-key 728 member1

(integer) 1

> zadd zset-key 982 member0

(integer) 1

> zadd zset-key 982 member0

(integer) 0

> zrange zset-key 0 -1 withscores

1) "member1"

2) "728"

3) "member0"

4) "982"

> zrangebyscore zset-key 0 800 withscores

1) "member1"

2) "728"

> zrem zset-key member1

(integer) 1

> zrem zset-key member1

(integer) 0

> zrange zset-key 0 -1 withscores

1) "member0"

2) "982"

三、数据结构

字典

/* This is our hash table structure. Every dictionary has two of this as we

* implement incremental rehashing, for the old to the new table. */

typedef struct dictht {

dictEntry **table;

unsigned long size;

unsigned long sizemask;

unsigned long used;

} dictht;

typedef struct dictEntry {

void *key;

union {

void *val;

uint64_t u64;

int64_t s64;

double d;

} v;

struct dictEntry *next;

} dictEntry;

typedef struct dict {

dictType *type;

void *privdata;

dictht ht[2];

long rehashidx; /* rehashing not in progress if rehashidx == -1 */

unsigned long iterators; /* number of iterators currently running */

} dict;

/* Performs N steps of incremental rehashing. Returns 1 if there are still

* keys to move from the old to the new hash table, otherwise 0 is returned.

*

* Note that a rehashing step consists in moving a bucket (that may have more

* than one key as we use chaining) from the old to the new hash table, however

* since part of the hash table may be composed of empty spaces, it is not

* guaranteed that this function will rehash even a single bucket, since it

* will visit at max N*10 empty buckets in total, otherwise the amount of

* work it does would be unbound and the function may block for a long time. */

int dictRehash(dict *d, int n) {

int empty_visits = n * 10; /* Max number of empty buckets to visit. */

if (!dictIsRehashing(d)) return 0;

while (n-- && d->ht[0].used != 0) {

dictEntry *de, *nextde;

/* Note that rehashidx can't overflow as we are sure there are more

* elements because ht[0].used != 0 */

assert(d->ht[0].size > (unsigned long) d->rehashidx);

while (d->ht[0].table[d->rehashidx] == NULL) {

d->rehashidx++;

if (--empty_visits == 0) return 1;

}

de = d->ht[0].table[d->rehashidx];

/* Move all the keys in this bucket from the old to the new hash HT */

while (de) {

uint64_t h;

nextde = de->next;

/* Get the index in the new hash table */

h = dictHashKey(d, de->key) & d->ht[1].sizemask;

de->next = d->ht[1].table[h];

d->ht[1].table[h] = de;

d->ht[0].used--;

d->ht[1].used++;

de = nextde;

}

d->ht[0].table[d->rehashidx] = NULL;

d->rehashidx++;

}

/* Check if we already rehashed the whole table... */

if (d->ht[0].used == 0) {

zfree(d->ht[0].table);

d->ht[0] = d->ht[1];

_dictReset(&d->ht[1]);

d->rehashidx = -1;

return 0;

}

/* More to rehash... */

return 1;

}

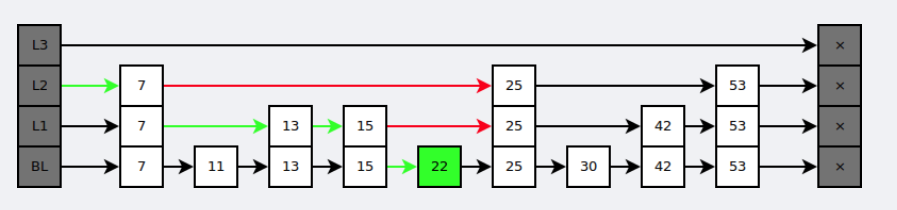

跳跃表

插入速度非常快速,因为不需要进行旋转等操作来维护平衡性;

更容易实现;

支持无锁操作。

四、使用场景

计数器

缓存

查找表

消息队列

会话缓存

分布式锁实现

其它

五、Redis 与 Memcached

数据类型

数据持久化

分布式

内存管理机制

在 Redis 中,并不是所有数据都一直存储在内存中,可以将一些很久没用的 value 交换到磁盘,而 Memcached 的数据则会一直在内存中。

Memcached 将内存分割成特定长度的块来存储数据,以完全解决内存碎片的问题。但是这种方式会使得内存的利用率不高,例如块的大小为 128 bytes,只存储 100 bytes 的数据,那么剩下的 28 bytes 就浪费掉了。

六、键的过期时间

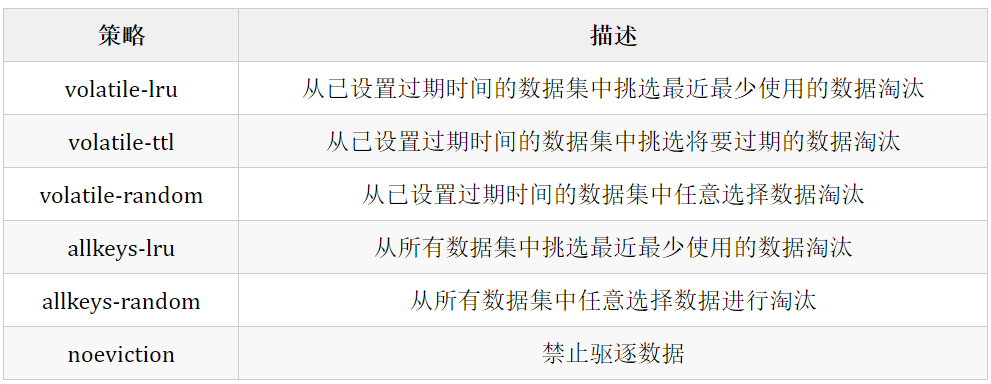

七、数据淘汰策略

八、持久化

RDB 持久化

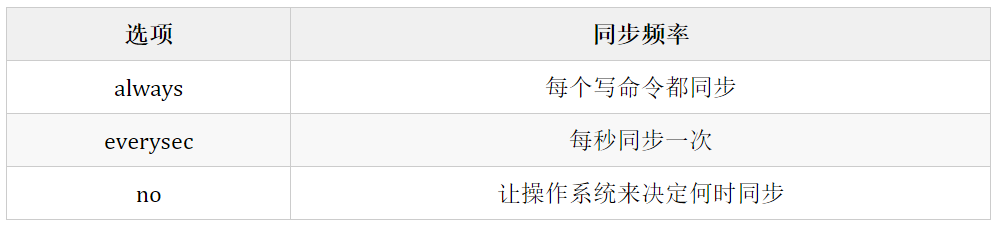

AOF 持久化

always 选项会严重减低服务器的性能;

everysec 选项比较合适,可以保证系统崩溃时只会丢失一秒左右的数据,并且 Redis 每秒执行一次同步对服务器性能几乎没有任何影响;

no 选项并不能给服务器性能带来多大的提升,而且也会增加系统崩溃时数据丢失的数量。

九、事务

十、事件

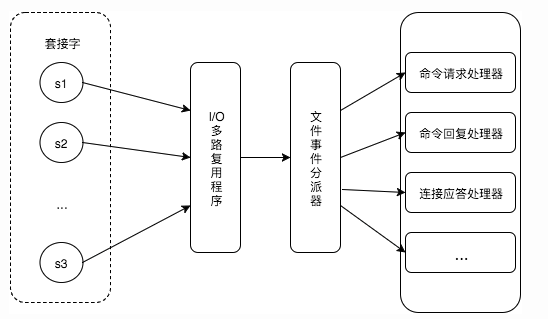

文件事件

时间事件

定时事件:是让一段程序在指定的时间之内执行一次;

周期性事件:是让一段程序每隔指定时间就执行一次。

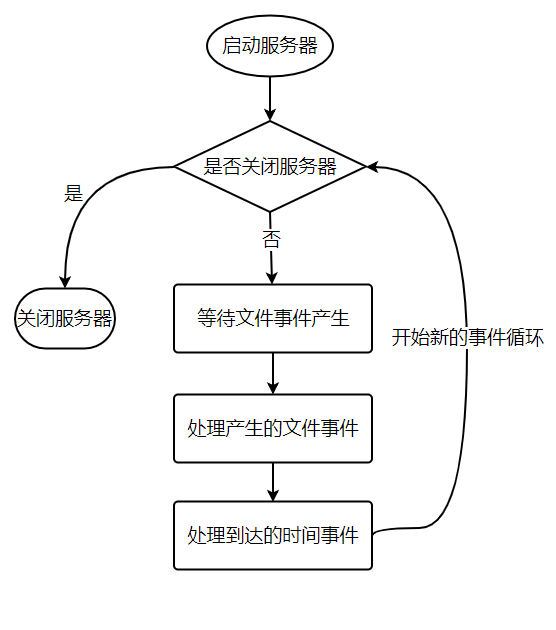

事件的调度与执行

def aeProcessEvents():

# 获取到达时间离当前时间最接近的时间事件

time_event = aeSearchNearestTimer()

# 计算最接近的时间事件距离到达还有多少毫秒

remaind_ms = time_event.when - unix_ts_now()

# 如果事件已到达,那么 remaind_ms 的值可能为负数,将它设为 0

if remaind_ms < 0:

remaind_ms = 0

# 根据 remaind_ms 的值,创建 timeval

timeval = create_timeval_with_ms(remaind_ms)

# 阻塞并等待文件事件产生,最大阻塞时间由传入的 timeval 决定

aeApiPoll(timeval)

# 处理所有已产生的文件事件

procesFileEvents()

# 处理所有已到达的时间事件

processTimeEvents()

def main():

# 初始化服务器

init_server()

# 一直处理事件,直到服务器关闭为止

while server_is_not_shutdown():

aeProcessEvents()

# 服务器关闭,执行清理操作

clean_server()

十一、复制

连接过程

主服务器创建快照文件,发送给从服务器,并在发送期间使用缓冲区记录执行的写命令。快照文件发送完毕之后,开始向从服务器发送存储在缓冲区中的写命令;

从服务器丢弃所有旧数据,载入主服务器发来的快照文件,之后从服务器开始接受主服务器发来的写命令;

主服务器每执行一次写命令,就向从服务器发送相同的写命令。

主从链

十二、Sentinel

十三、分片

最简单的方式是范围分片,例如用户 id 从 0~1000 的存储到实例 R0 中,用户 id 从 1001~2000 的存储到实例 R1 中,等等。但是这样需要维护一张映射范围表,维护操作代价很高。

还有一种方式是哈希分片,使用 CRC32 哈希函数将键转换为一个数字,再对实例数量求模就能知道应该存储的实例。

客户端分片:客户端使用一致性哈希等算法决定键应当分布到哪个节点。

代理分片:将客户端请求发送到代理上,由代理转发请求到正确的节点上。

服务器分片:Redis Cluster。

十四、一个简单的论坛系统分析

可以发布文章;

可以对文章进行点赞;

在首页可以按文章的发布时间或者文章的点赞数进行排序显示。

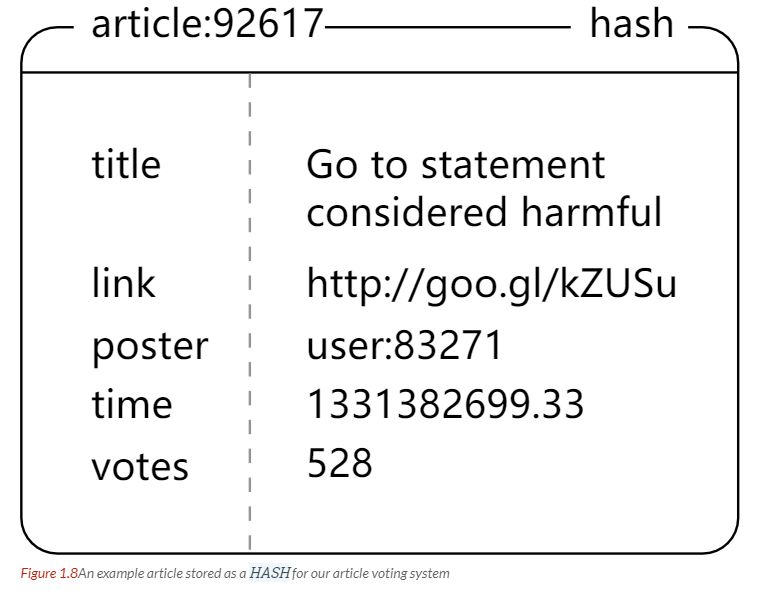

文章信息

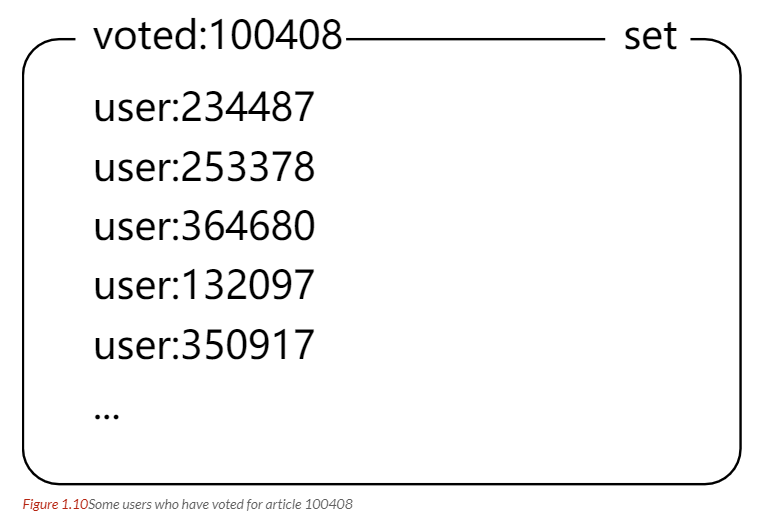

点赞功能

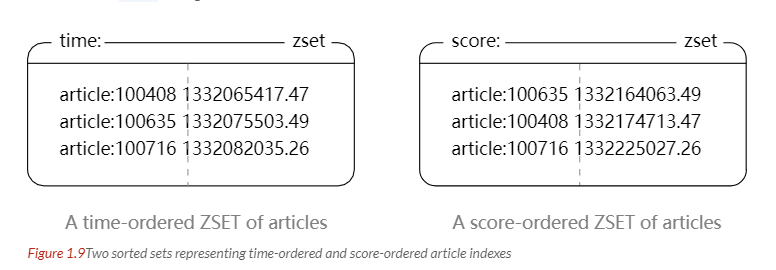

对文章进行排序

参考资料

Carlson J L. Redis in Action[J]. Media.johnwiley.com.au, 2013.

黄健宏. Redis 设计与实现 [M]. 机械工业出版社, 2014.

REDIS IN ACTION

Skip Lists: Done Right

论述 Redis 和 Memcached 的差异

Redis 3.0 中文版- 分片

Redis 应用场景

Using Redis as an LRU cache

推荐阅读:

微信扫描二维码,关注我的公众号

朕已阅