腾讯员工总结:python后端开发架构的演进

作者:硅步 来源:zhu327.github.io/2018/07/19/python后端架构演进/

来腾讯之前在前公司做了3年的后端开发,经历一款SaaS产品从0到10(还没有到100, 哈哈哈)的过程,3年间后端的架构逐步演变,在微服务的实践过程中遇到的问题也越来越多,在这里总结下。

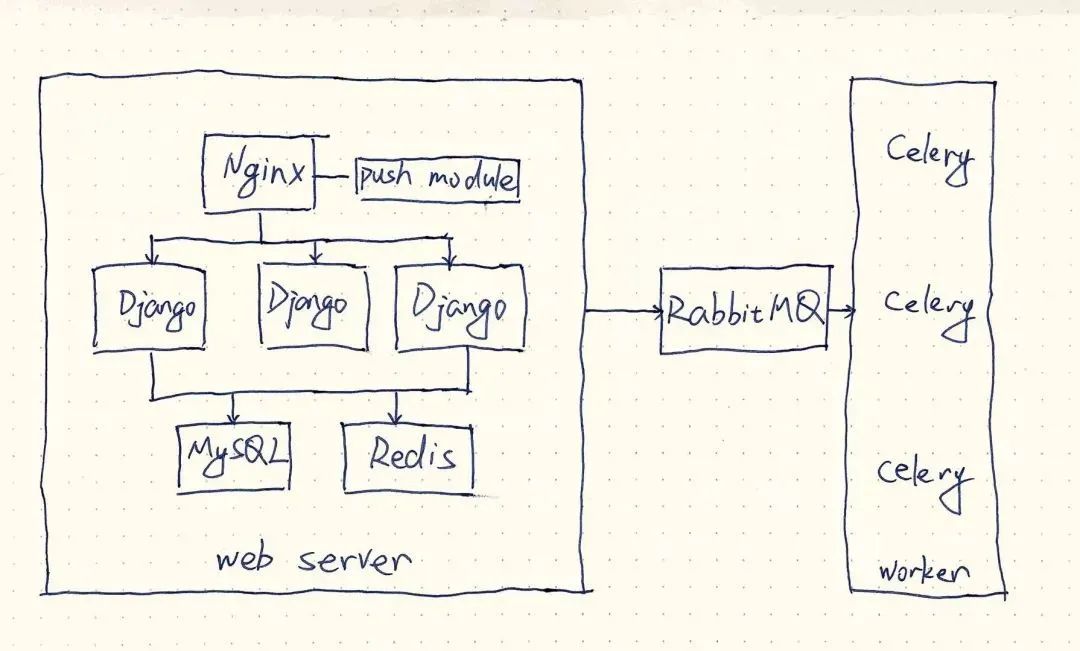

1. MVC

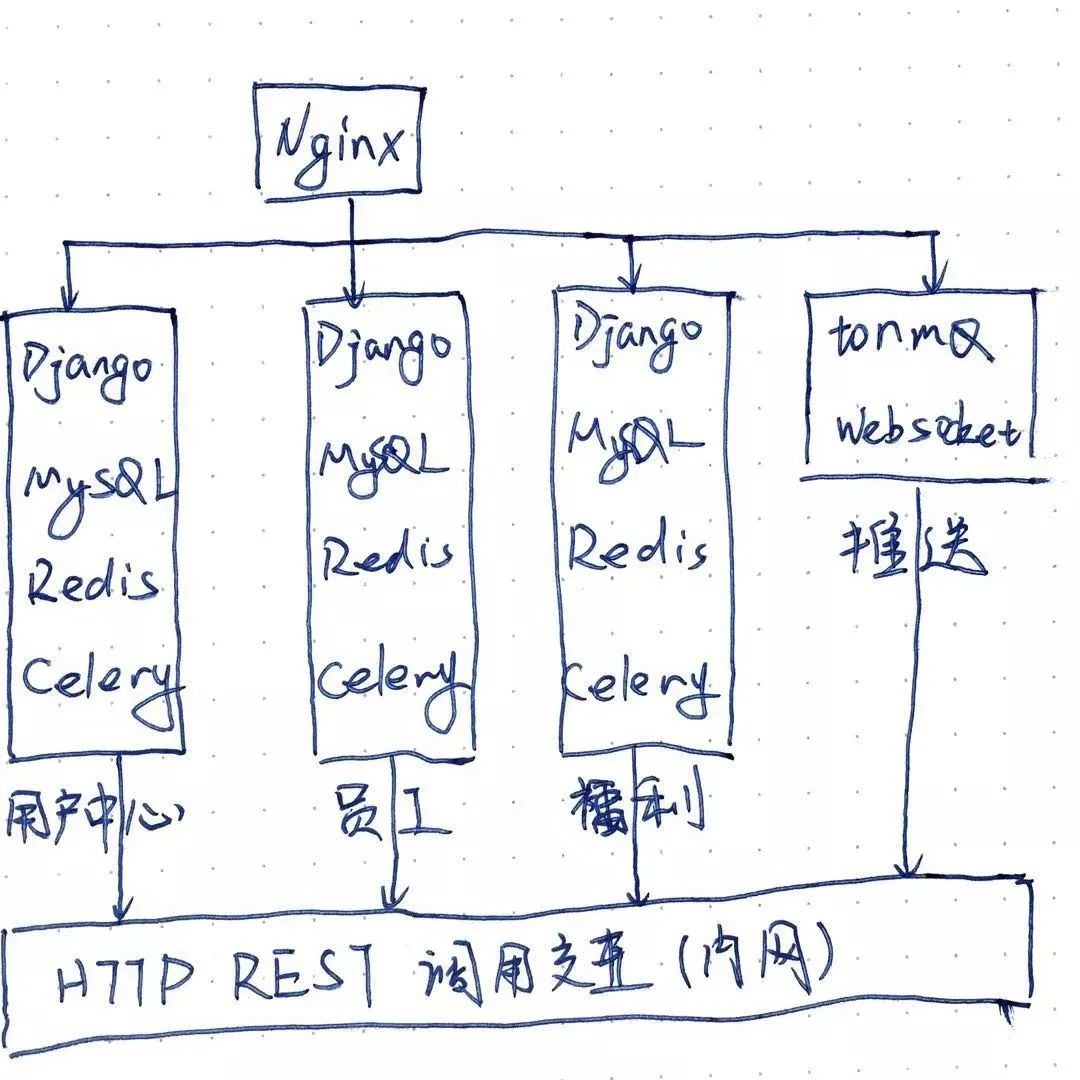

2. 服务拆分

Nginx Push Module由于长时间没有维护,长连接最大数量不够,使用Tornado + ZeroMQ实现了tormq(https://github.com/zhu327/tormq)服务来支撑消息通知

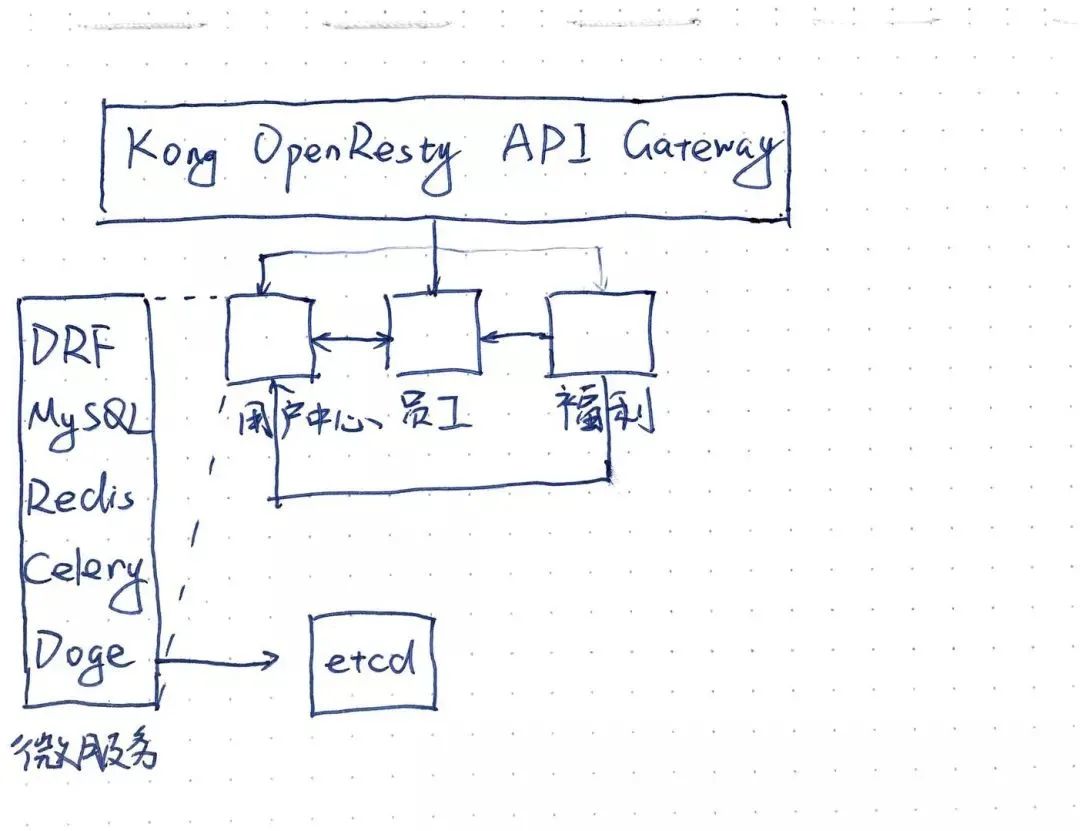

3. 微服务架构

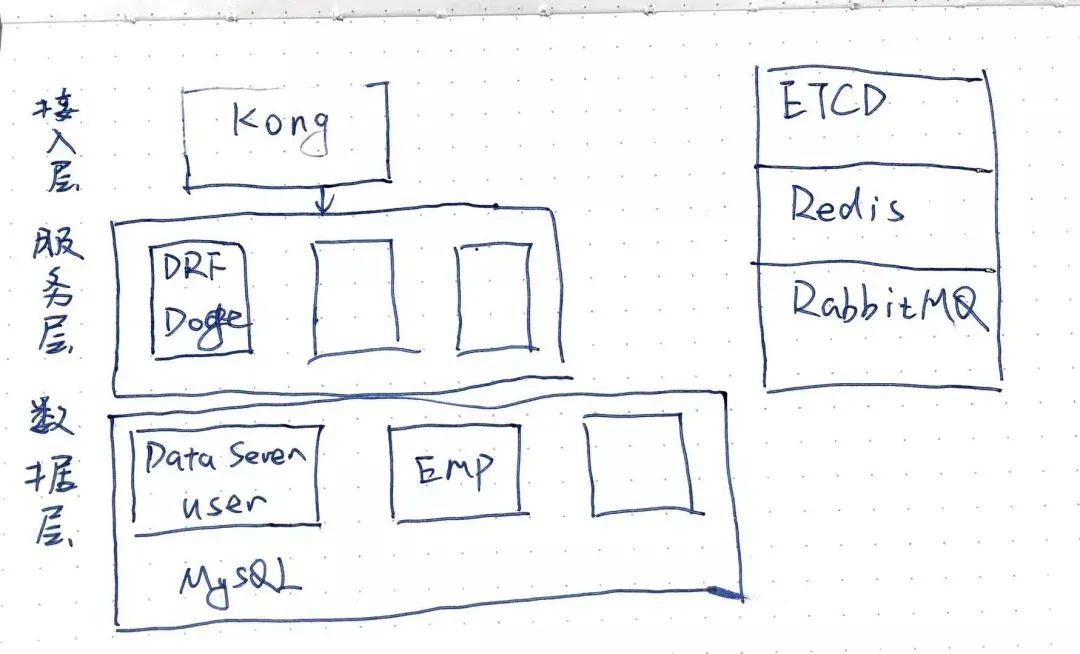

4. 领域驱动设计

# 总结

看完本文有收获?请转发分享给更多的人

关注「神奇的老黄」 学习更多的技术

评论