面试官:运行 100 万个并发任务需要多少内存?问倒一大片。。。

在计算机科学中,并发任务是指同时执行的多个任务。当我们需要运行大量的并发任务时,我们需要考虑内存的使用情况。本文将讨论在运行100万个并发任务时所需的内存量,并提供一些代码示例和注释。

首先,我们需要明确每个并发任务所需的内存量。假设每个任务需要占用1MB的内存空间。那么100万个并发任务将需要100万MB的内存,即1000GB或1TB的内存。

接下来,我们可以使用多线程或异步编程来实现并发任务。下面是一个使用Python的多线程示例代码:

import threading

def task():

# 执行任务的代码

pass

# 创建100万个线程

threads = []

for _ in range(1000000):

t = threading.Thread(target=task)

threads.append(t)

# 启动所有线程

for t in threads:

t.start()

# 等待所有线程完成

for t in threads:

t.join()

在上面的代码中,我们创建了100万个线程,并将它们添加到一个列表中。然后,我们依次启动每个线程,并使用join()方法等待所有线程完成。

请注意,上述代码只是一个示例,实际情况可能会更加复杂。例如,您可能需要使用线程池或其他并发库来管理并发任务。

另一种实现并发任务的方法是使用异步编程。下面是一个使用Python的asyncio库的示例代码:

import asyncio

async def task():

# 执行任务的代码

pass

# 创建一个事件循环

loop = asyncio.get_event_loop()

# 创建100万个任务

tasks = []

for _ in range(1000000):

t = asyncio.ensure_future(task())

tasks.append(t)

# 执行所有任务

loop.run_until_complete(asyncio.wait(tasks))

在上面的代码中,我们创建了100万个任务,并将它们添加到一个列表中。然后,我们使用asyncio.ensure_future()方法将每个任务转换为一个Future对象。最后,我们使用asyncio.wait()方法执行所有任务。

需要注意的是,异步编程通常需要更少的内存,因为它可以更有效地利用计算资源。但是,具体的内存使用情况取决于任务的性质和实现方式。

总结起来,运行100万个并发任务所需的内存量取决于每个任务所需的内存量以及任务的实现方式。在本文中,我们提供了使用多线程和异步编程的示例代码,并讨论了内存使用情况。然而,实际情况可能因系统配置和任务的特性而有所不同,因此在实际应用中需要进行更详细的测试和评估。

所以,我在网上找到一篇文章,作者对不同的语言如:Rust、Go、Java、C#、Python、Node.js 和 Elixir 等流行编程语言在异步和多线程编程中的内存消耗对比。

结果如下:

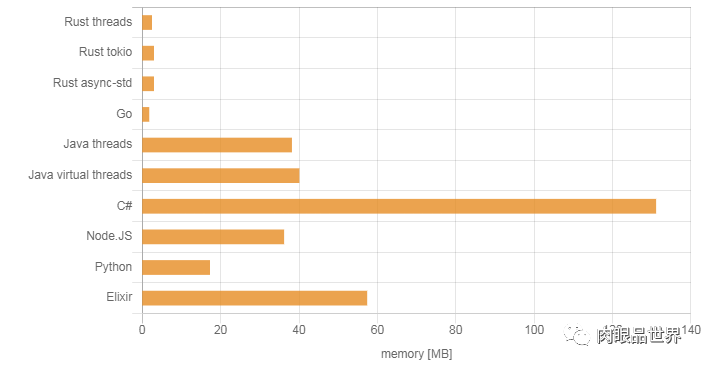

launch only one task

从上图中的结果可以看出,Go 与 Rust 程序消耗的内存非常少,其次是 Python,.NET 的内存占用最大。

从上图中的结果可以看出,Go 与 Rust 程序消耗的内存非常少,其次是 Python,.NET 的内存占用最大。

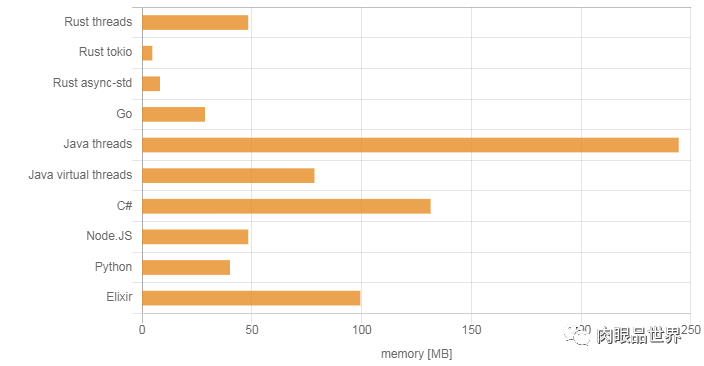

10k Tasks

从上图结果可以看出,消耗内存最大的是Java,.NET没有很大的明显变化,其它几个变化不是很明显。

从上图结果可以看出,消耗内存最大的是Java,.NET没有很大的明显变化,其它几个变化不是很明显。

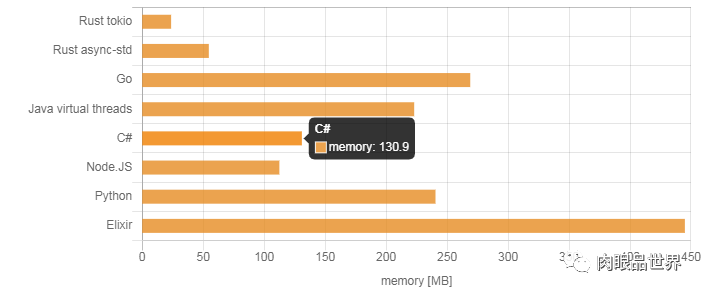

100k Tasks

这次结果,我们看到了一些很明显的变化。Go 和 Python 消耗的内存迅速增长,而 Java 虚拟线程,Rust async 和 Node.JS 保持相对较低的内存消耗。.NET 内存使用量仍然没明显增加。

这次结果,我们看到了一些很明显的变化。Go 和 Python 消耗的内存迅速增长,而 Java 虚拟线程,Rust async 和 Node.JS 保持相对较低的内存消耗。.NET 内存使用量仍然没明显增加。

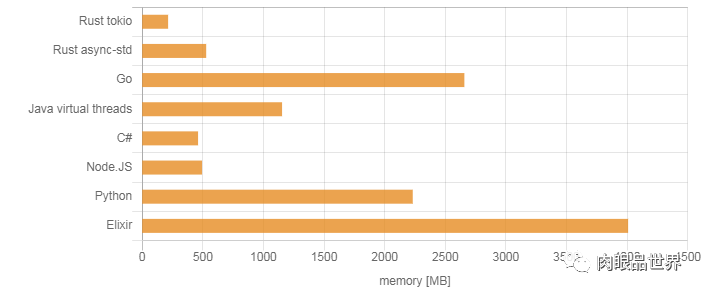

1 Million Tasks

从上面的结果看出,只有 Rust async(无论是 tokio 还是 async-std)、Java 虚拟线程和 .NET 可以运行。Go,Python 和 Node.JS 运行后直接耗尽测试机的系统内存(16GB),没能完成基准测试。

从上面的结果看出,只有 Rust async(无论是 tokio 还是 async-std)、Java 虚拟线程和 .NET 可以运行。Go,Python 和 Node.JS 运行后直接耗尽测试机的系统内存(16GB),没能完成基准测试。

总结

我发现它们在内存消耗上差异巨大,有时甚至超过了 20 倍。某些程序仅消耗略超过 100 MB 内存,而其他程序在处理 10k 连接时内存消耗了将近 3GB。这些程序都相当复杂,且特性各不相同,因此难以直接比较并得出有意义的结论。

参考:https://www.shili8.cn/article/detail_20001790008.html https://pkolaczk.github.io/memory-consumption-of-async/

推荐阅读: