优酷戴洵:大型活动直播沉浸式体验的技术解密

近年来多视角、自由视角、XR/AR等等新兴技术的出现为直播形态发展提供了无限可能,应用场景与市场需求渗透促进,如今视频直播越来越强调为用户打造可交互、超高清、沉浸式的观看体验,

优酷直播技术负责人戴洵在7月8日的阿里云直播峰会上分享了《大型活动直播沉浸式体验的技术解密》主题演讲,对大型活动直播中多视角、自由视角、XR直播技术应用场景与技术链路进行了全面解读,深入分析了当前环境下大型活动直播的供需变化。以下为整理内容:

随着技术的发展与基础设施的夯实,大型活动直播在供需上产生了多方面变化:

大型现场节目需求从线下往线上溢出;

用户越来越愿意为线上直播付费;

用户更偏向为沉浸感内容买单;

而作为平台与创作者,也更愿意制作线上的、沉浸式的内容:如综艺节目、体育赛事以及艺术演出,都开始尝试多视角、自由视角、XR的直播形式,大型沉浸式直播的行业应用场景不断拓宽,覆盖产业范围持续扩大。

本次分享也将重点从以上三种直播技术的挑战、实践、应用去展开。

多视角在大型活动直播中的应用场景广泛,如演唱会、晚会、体育赛事等,但是在技术实践上仍然存在诸多挑战:

首先是无法实现多画预览,如果采用拉多路流的方式实现多画预览将导致占满带宽,造成卡顿率飙升。

其次,拉多路流难以实现时间轴对齐,如果采用点击按钮刷新播放器的方式来完成切换流的工作,则每次切换都需要重新加载数据,破坏用户体验。

重新加载还会造成时间轴跳跃的问题,在解码过程中从最近GOP的第一帧开始播放,如果有多个视角同时切换流,画面将发生回跳。

针对上述挑战,提出的技术方案需实现平滑切换、快速切换、同时预览。方案中共包含四个部分:现场、中心、边缘、端:

多个机位将信号输出给导播台,再由导播人员输入信号并将不同机位信号供给编码集群,编码集群对信号进行编码并上传到云。需要强调的是,编码集群时间戳提前对齐,在推流时将对齐的时间戳加入对应流的metadata。

根据metadata对多个视角的流进行帧对齐,同时将每一路视角的大小画面关系进行枚举,多视角直播服务需将云导播拼接完成的每一路流进行下载缓存,当接收到端侧的切流信令后,切换相应的音视频数据,使用RTP协议进行渲染。

为了离用户更近需要将多视角直播服务部署到边缘云,结合RTP协议做到更低延时,提升切流操作的体验。

最后需要将多个视角的流通过绝对时间戳进行帧对齐,在收到流后进行解码、拆分画面,并且渲染成为可交互式的播放器。

以上就是一个完整的多视角直播技术链路。

值得注意的是,多视角直播服务不需要对云导播输出的所有信号进行解码,也不需要对发送给播放器的数据进行编码。为了避免大量消耗计算资源,只需要将对应流的音视频数据拷贝并通过RTP协议发送给播放器。

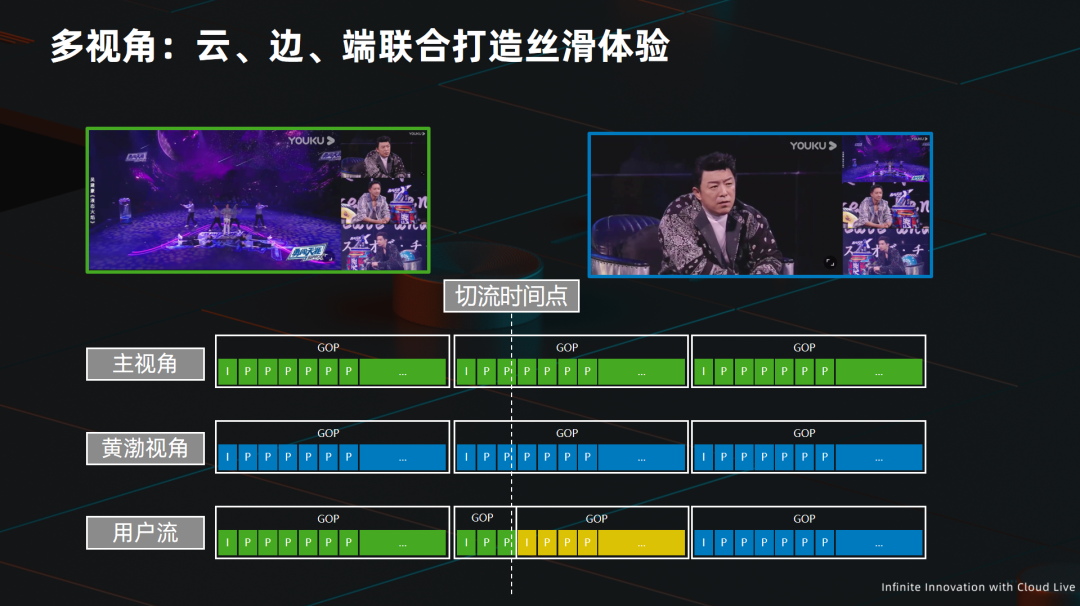

图中绿色与蓝色的流分别为主舞台视角与演出嘉宾的视角,最底层的一路代表发送给播放器的用户流。

切换视角前,拷贝绿色的流;切换视角后,拷贝蓝色的流。如果切换发生在GOP中间位置,立刻结束当前拷贝的GOP,将剩余的GOP用蓝色流重新编码,以形成一个新的GOP,即图中黄色部分,再继续拷贝蓝色流。

采取上述技术方案能够实现平滑切换同时节省大量计算资源。

自由视角与VR类似,都属于6DoF视频,是对3D视频的一种呈现:

VR从一个点向外、向多个角度去看,适用于从一个点环顾全场的场景。

自由视角从外向内看,适用于多个视角聚焦观看舞台场景。

自由视角直播应用场景主要包括赛事直播与综艺直播,用于为节目呈现特定效果。

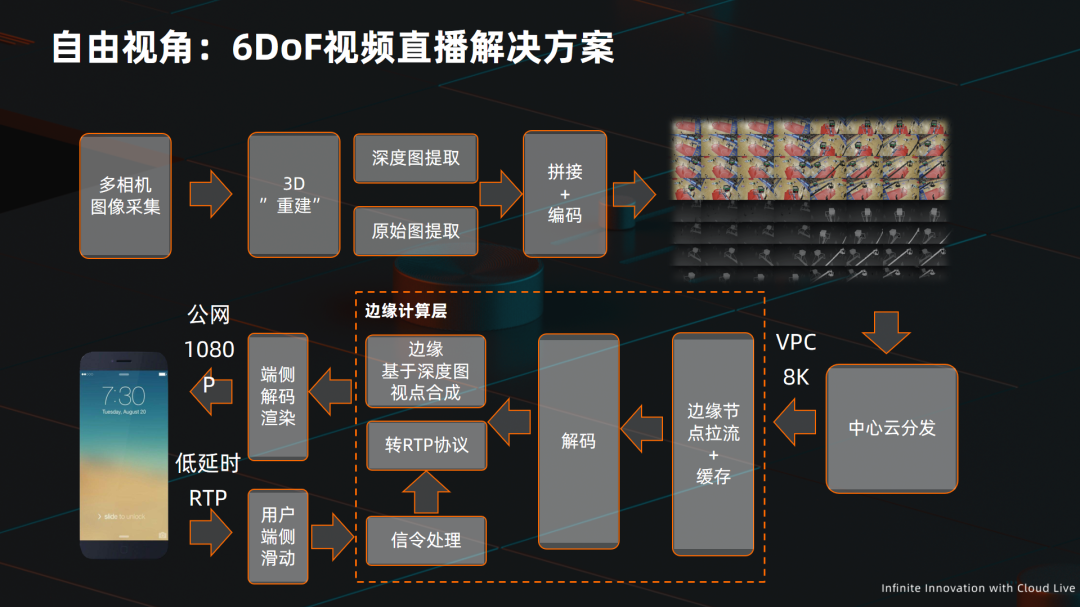

下图展现了自由视角直播技术完整链路以及核心技术点:

采集系统包含了36个相机部署在150°的圆弧形支架上,并且对每一路相机进行标定。采集系统将36路信号以及标定的数据同时输出给3D“重建”服务。

3D“重建”服务是对原始画面以及深度图进行提取的过程。原始图像为二维,每一个像素点具有X\Y坐标,如果加上Z坐标即可完整描述3D画面,深度图就具备添加Z坐标的作用。深度图通过相机原始画面与标定数据共同计算得出。

在提取出原始画面与深度图后,将二者进行拼接,形成图中右上角的画面,即一个完整描述的3D图像画面,并对其进行编码。

最后将完整描述的3D图像画面通过CDN分发到端侧进行渲染。端侧在收到流后进行解码,并将拼接画面因素拆分,最后进行上屏渲染。

此处需要强调的是,36路相机无法做到150度范围内每一度的精准切换,由于每两个相机间间隔4°,所以存在2°范围的空白,需要使用基于深度图的视点合成技术来实时生成,最终达到一度精度的切换体验。

以上技术方案应用到直播场景还面临着一系列挑战:

首先是采集上传的挑战。由于3D重建需要计算深度图,过程耗费大量计算资源。另外为保证视频清晰度,拼接后的3D视频通常能够达到8K分辨率,对其进行编码同样需要耗费大量计算资源。

其次是客户端下载8K视频过程中带宽带来的压力。由于8K视频往往码率在200M上下,普通用户很难达到对应网络条件。即使是下载到终端,对于终端造成的渲染压力也是巨大的,并且还需要对空白的视点进行实时合成。

为了解决上述问题,引入了边缘计算层,将8K视频解码过程与视点合成工作部署到边缘云。端侧与边缘云通过低延时的RTP协议传输视频信号与切换信令,能够有效缓解计算、带宽压力。采集上传的压力则是通过特定的硬件与板卡集成来满足需求,比如集成多路的SDI采集卡与FPGA板卡。

XR直播技术应用场景表现为帧享数字影棚XR制作系统,能够让真实的舞者完全融入虚拟的空间。

舞台包含了真实LED背景舞台,而舞台外的虚拟背景与AR前景叠加则是由制作系统中的虚拟渲染引擎实时渲染拼接而成。最后监视器中的画面通过XR系统制作输出,已经包含了完整的扩展背景与叠加后的AR前景。

XR制作系统的技术链路如下图所示:

首先在摄像机上安装摄像跟踪系统,实时跟踪摄像机位置与焦距等信息,并实时输出给虚拟渲染服务。虚拟渲染服务根据摄像跟踪系统将虚拟空间内容进行渲染,通过LED背景投射系统投射到LED背景舞台,令摄像机采集到的视频信号同时包括真实的舞者与LED背景与渲染过后的虚拟背景。

最终虚拟渲染服务收到摄像机采集信号,结合摄像跟踪系统信号,对真实LED背景屏进行拓展,叠加AR前景,形成PGM直播信号。

多视角、自由视角、XR直播技术的出现将线下活动以全景无死角、互动性更强、沉浸度更深的方式展现在观众面前,满足了观众对于大型活动直播日益增长的观看需求,推动了直播产业发展,为行业带来了全新机遇。