Tengine-Lite开源了!新一代AI端侧推理框架

OPEN AI LAB(开放智能)于7月6日正式开源拥有自主知识产权的全新下一代AI端侧推理框架Tengine-Lite。作为Tengine整体软件架构重构的全新下一代产品,Tengine-Lite的推出不仅为开发者提供了整套便捷的MCU AI开发工具,还为嵌入式AI软件产业建立了开放的开发生态平台。

基于纯C代码重新搭建的更简洁、高效、代码可读性更好的Tengine-Lite,可以说将轻量化无依赖做到了极致。特别适合在各种软硬件资源受限的嵌入式环境下使用部署轻量的AI算法模型,并可用于语音、视觉等多种场景。

AI风口下,新秀Tengine-Lite C位出道,都有哪些不容错过的看点呢?

Tengine-Lite,驱动最强大脑

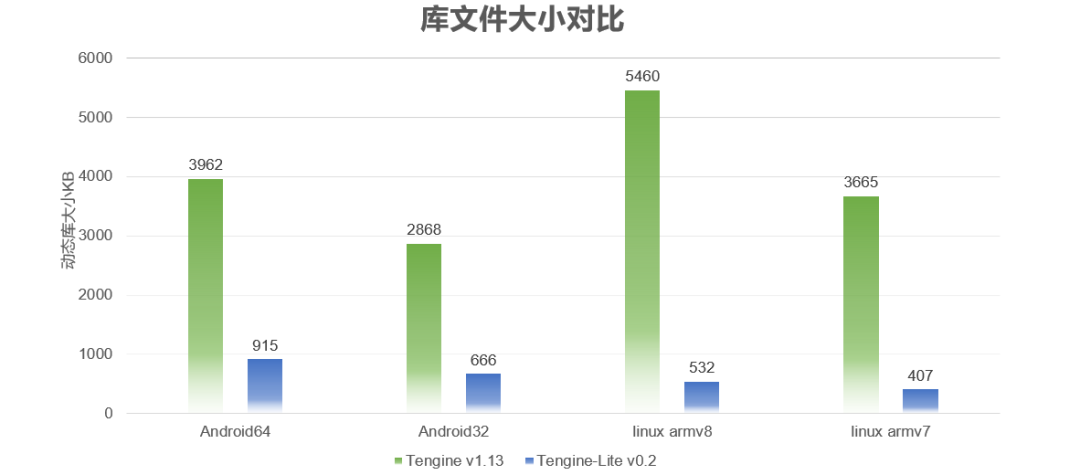

越来越多的手机市场用户,会在意APP的大小。当然,IoT领域用户也不例外。在低功耗的浪潮下,芯片越来越倾向于片上SRAM与Flash的结构。Tengine-Lite二进制文件库(包括.a静态库与.so的动态库)大小急剧减小,以.so动态库为例,Tengine-Lite库文件大小相较Tengine,较小非常显著。项目链接如下:

https://github.com/OAID/Tengine/tree/tengine-lite目前安卓的库大小在1MB以内,Linux版本在500KB以内。

Tengine-Lite,独具高效思维

Tengine-Lite采用前后端松耦合设计,框架和计算库采用Plug-in,可以更好地保证后续异构后端的灵活挂载。同时,Tengine-Lite高效的运作思维,使得源代码编译时间大幅缩减,极大的增强了用户代码编译的体验感。

Tengine-Lite,给你“稳稳的幸福”

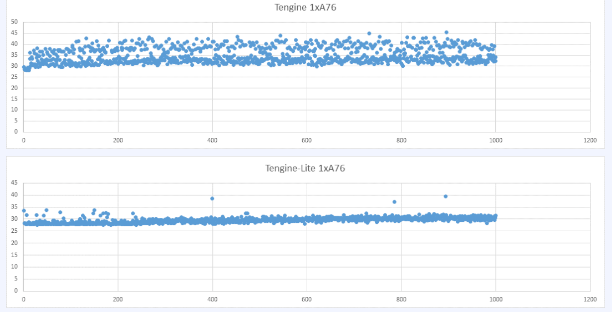

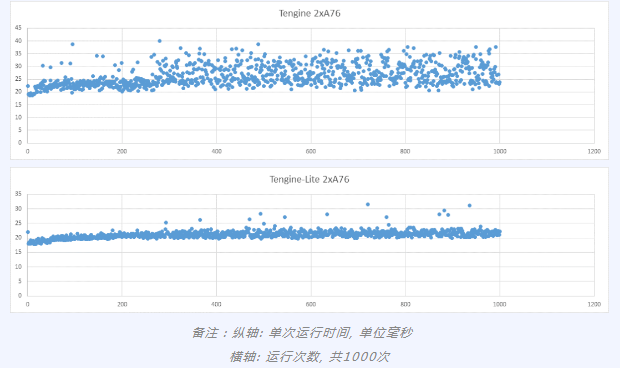

性能抖动会对嵌入式平台和手机平台的系统性能设计、用户使用体验带来较大影响。考虑到这一点,Tengine-Lite在单核、双核、多核的性能稳定性方面,相较Tengine有明显提升。

Tengine-Lite,用智慧“流畅运行”

架构重构后兼容性方面,也是用户比较关心的。现有以下四点说明:

1、NNIR模型格式保留现有tmfile格式,兼容当前应用,用户现有tmfile模型可以无缝切换到新的Tengine-Lite上运行;

2、编译方式统一,采用CMake进行编译管理,并将新增一些编译配置选项(新功能和新特性);

3、依旧提供.so动态库和.a静态库形式,若想不修改代码可以通过rename库文件的方式进行代码复用;

4、保留绝大多数常用API不变,会增减部分API。原则是删减对用户无效或极少使用的API,新增API主要是功能性的,更改的API是提升用户反馈的易用性;当然也会提供API修改对比文档。

如果您想了解更多Tengine-Lite的功能、应用信息,请扫描下面的二维码加入技术交流QQ群,有数位行业大佬坐镇,随时与我们沟通。

全新下一代AI端侧推理框架

Tengine-Lite GitHub开源链接

https://github.com/OAID/Tengine/tree/tengine-lite

欢迎大家Star、Watch、Fork三部曲

▼

整理不易,请给CVer点赞和在看!![]()