未来移动端的“最强AI引擎”百度华为如何打造?

这是Han的第71篇原创文章

今天,咱们聊聊手机和AI。

先说一个最新的段子。

华为今年的Mate 30 Pro有一个最新的功能。可以用AI自动检测有几个人在盯着你的手机。

如果只有你自己在看,那通知就会显示全文。如果同时还有别人在看,那通知就会折叠隐藏。 于是,最恐怖的一幕就是:深夜,你一个人在家,Mate 30 Pro把通知隐藏了。 其实,今年的各大厂新旗舰手机,AI绝对还是亮点。 谷歌Pixel 4的GoogleAssistant支持多任务处理,和朋友聊天的时候,你可以随时问问看自己的航班情况。

如果只有你自己在看,那通知就会显示全文。如果同时还有别人在看,那通知就会折叠隐藏。 于是,最恐怖的一幕就是:深夜,你一个人在家,Mate 30 Pro把通知隐藏了。 其实,今年的各大厂新旗舰手机,AI绝对还是亮点。 谷歌Pixel 4的GoogleAssistant支持多任务处理,和朋友聊天的时候,你可以随时问问看自己的航班情况。

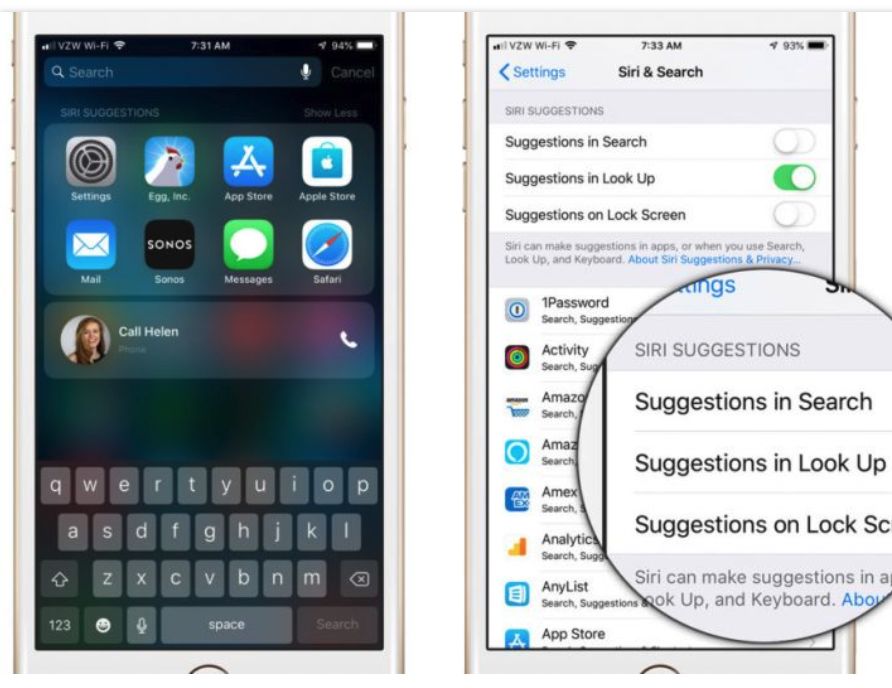

这些新体验背后,都有着AI的加持。 手机的AI是不是伪需求? 8年前,iPhone 4s推出最新功能Siri,语音识别正式“实用化”开始,人们开始相信AI的用处。

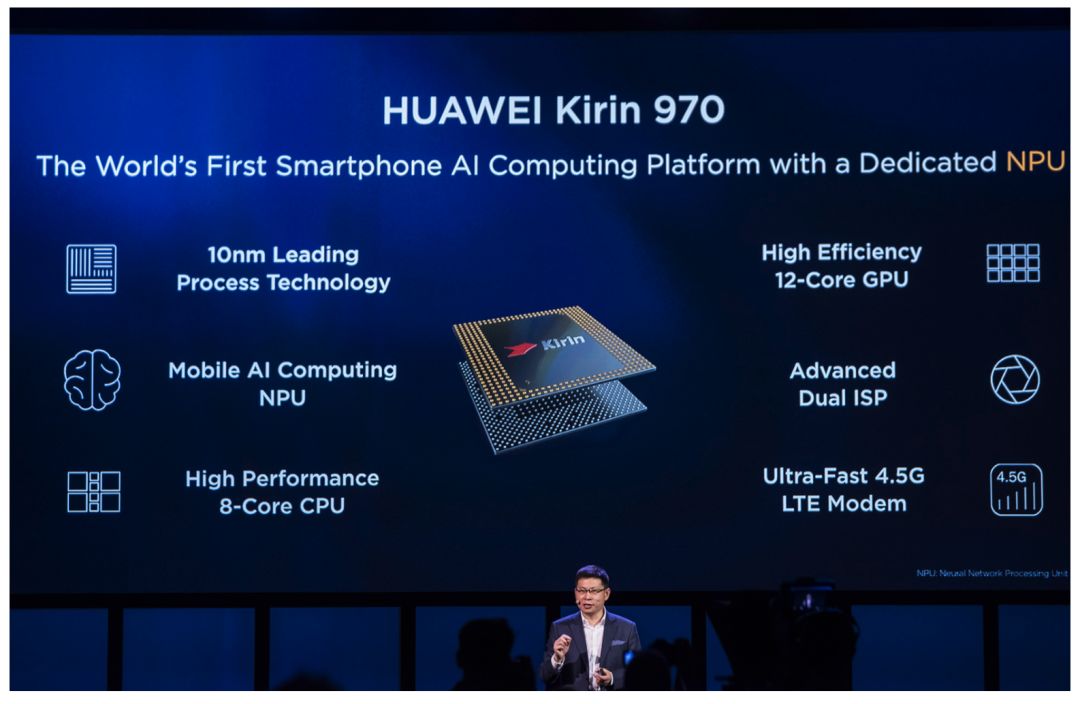

手机上的AI,需要专门的硬件么? 2年前,华为推出麒麟970芯片,内部搭载NPU单元,助力AI计算。也使得当年的Mate 10成为全球第一款搭载NPU的智能终端。

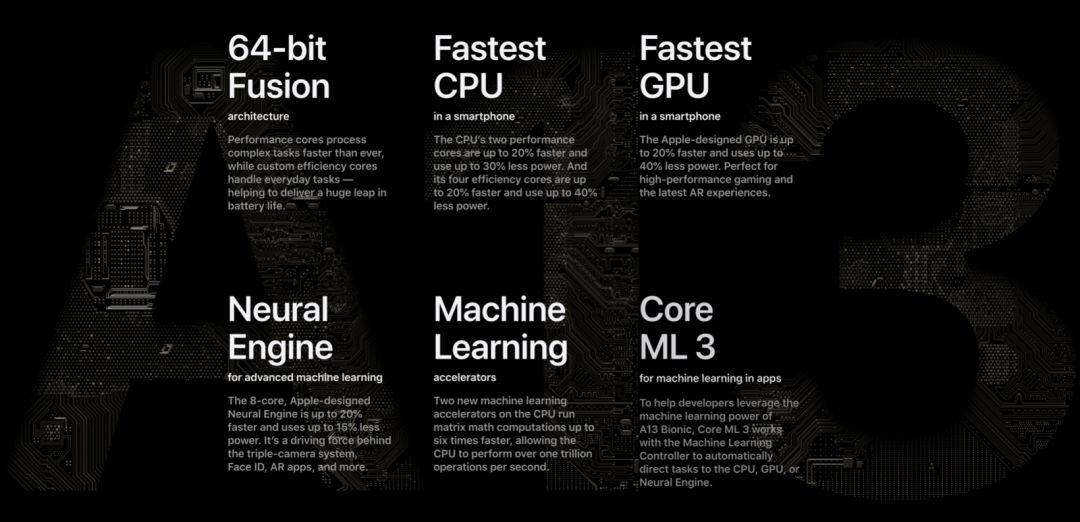

今天,移动端+ 芯片硬件,已经是各大厂的标配。同时,为了更多释放AI能力,都开放了各类接口和工具给到了开发者。 iPhone11 Pro的最新A13自研芯片,内部搭载8核神经引擎,助力Face ID等功能。

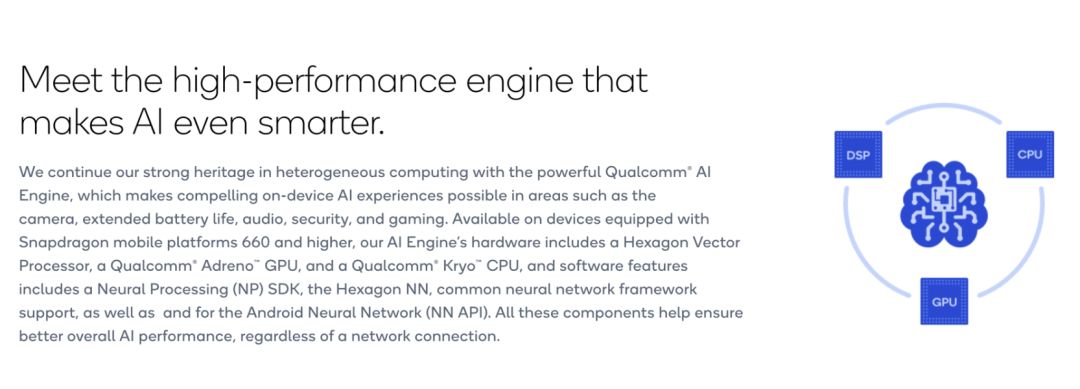

开发者方面,iOS则升级套件到CoreML 3,方便打造各类AI应用。 安卓方面,骁龙660平台开始,就已经引入AI计算引擎,去年底的855正式硬件加入Tensor Core计算单元。

开发者方面,更是推出Neural Processing (NP) SDK,以及和安卓深度耦合的Android Neural Network API。 华为除了硬件,还搭建了面向智能终端的AI能力开放平台HiAI。 而今年7月,百度飞桨(PaddlePaddle)深度学习平台与华为麒麟芯片正式宣布联手。

中国首个全面开源开放、技术领先、功能完备的产业级深度学习平台,和全球领先的最强“国产芯”华为麒麟系列联手,正式打通深度学习框架与芯片,为AI时代打造最强算力。 本周,在刚刚结束的“WAVE SUMMIT+”2019深度学习开发者秋季峰会上,刚刚入选“2019世界互联网大会领先科技成果”的飞桨全新发布了9大新产品和12项升级。

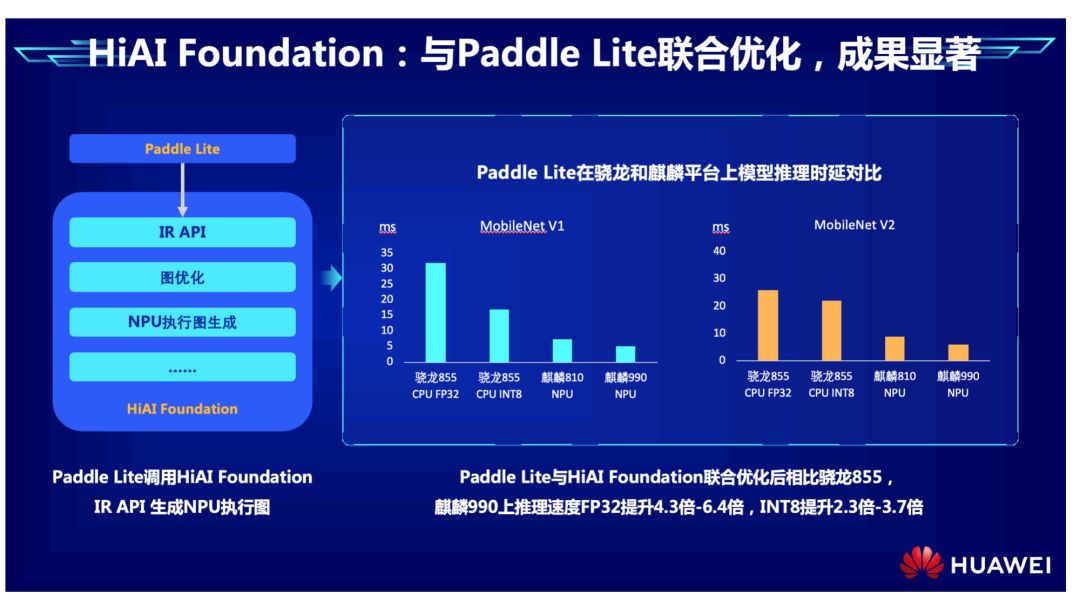

重点的是,最新的移动端侧推理引擎Paddle Lite 2.0,不仅支持ARM CPU 、 Mali GPU 、 Adreno GPU,还成为了第一个,支持华为 NPU 在线编译的深度学习推理框架。 两大“国货之光”也给出了最新成绩。

重点的是,最新的移动端侧推理引擎Paddle Lite 2.0,不仅支持ARM CPU 、 Mali GPU 、 Adreno GPU,还成为了第一个,支持华为 NPU 在线编译的深度学习推理框架。 两大“国货之光”也给出了最新成绩。

PaddleLite与HiAI Foundation联合优化后,相比骁龙855,麒麟990上推理速度FP32提升4.3倍-6.4倍,INT8提升2.3倍-3.7倍。 看到这,可能很多小伙伴还有疑问:这么强的AI算力,在手机上,真的有用吗? 当然,下面我就举出几个常见的手机应用案例。 AI的核心能力,是可以读懂文字,看懂图片。 我们每天要通过手机接触大量的文字:工作的短信消息,邮件,还有阅读新闻和公众号文章。

图像应用方面就更多了。你使用的P图软件,视频滤镜,都有AI的相关能力。这些都需要图像分割技术。 而PaddleSeg的开发套件,提供18个预训练模型,可以帮助开发者快速实现相关功能。 有时候,你看到明星的衣服很好看,想用图片搜索找找同款,这个时候就要用到目标检测技术了。还有,你家里如果使用了智能摄像头,可以快速捕捉移动物体,安全防盗,也要利用这个技术。

同样类似的,很多App都有超级多菜单,超多功能,怎样找到最合适的给你优先显示呢?这里也需要CTR模型。 而飞桨本次,则新增了ElasticCTR,可实现分布式CPU训练,可以为开发者快速解决上面的CTR应用问题。 有很多人觉得,5G时代已经来临,再过几年就将全面普及。到时候,我们还需要在移动端的AI能力么?NPU是不是就没有用了呢?

此外,5G最重要的应用场景就是IoT物联网。以后,接入网络的可不一定就是手机,小到水杯,大到工业机床都可能入网,实现万物互联。 到时候,这些移动设备可不见得有手机那样的强大能力,内存和网络能力可能都赶不上。那么,我们能不能把模型压缩到足够小,让这些设备方便使用,就是一个技术难点。 PaddleSlim则提供了强大的模型压缩能力,通过剪枝、量化、蒸馏,和全新的LightNAS,可以实现模型的精度无损压缩。

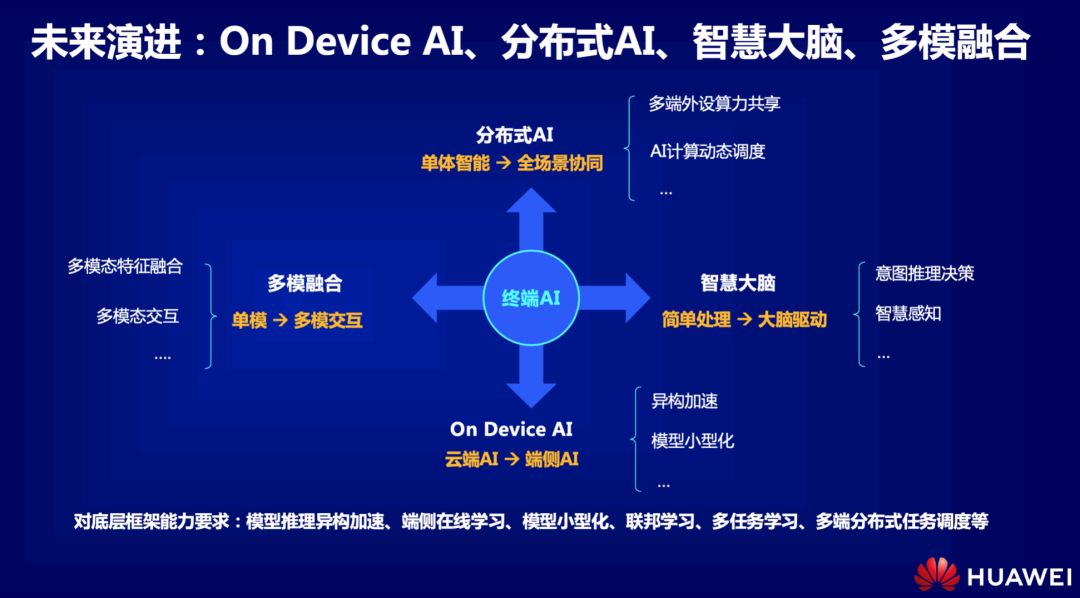

另外,最重要的,移动端设备上的AI,可以保证数据保留在本地,实现强大的数据安全。 比如,你的人脸识别解锁的数据,指纹的数据,还有其他更敏感的,比如身体的健康数据,都将本地安全留存。 以上,在设备上运行的AI,称之为OnDevice AI。这个能力,也将会是以后移动端AI发展的方向之一。 此外,华为HiAI和飞桨还将在哪些能力上下功夫?

另外,最重要的,移动端设备上的AI,可以保证数据保留在本地,实现强大的数据安全。 比如,你的人脸识别解锁的数据,指纹的数据,还有其他更敏感的,比如身体的健康数据,都将本地安全留存。 以上,在设备上运行的AI,称之为OnDevice AI。这个能力,也将会是以后移动端AI发展的方向之一。 此外,华为HiAI和飞桨还将在哪些能力上下功夫?

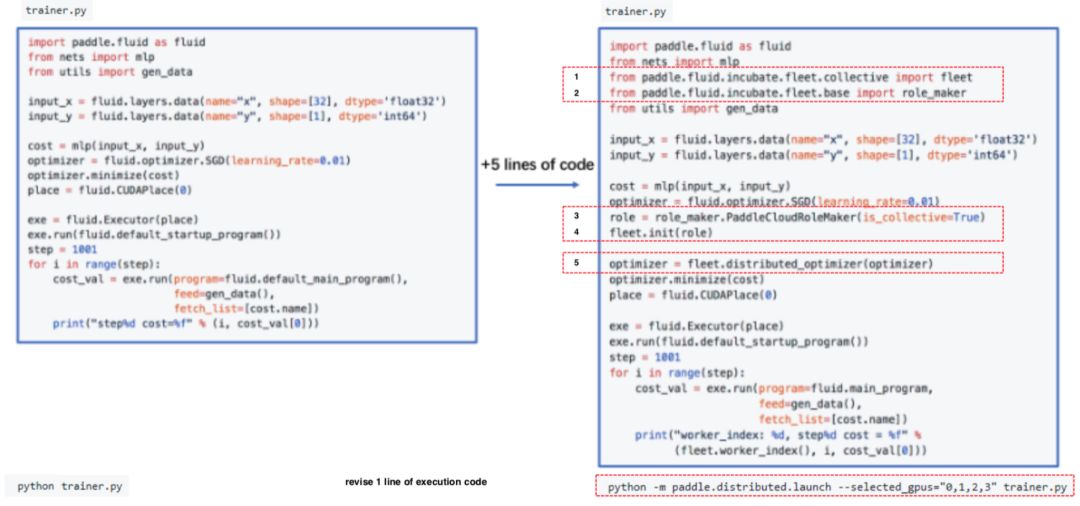

今年谷歌和华为都加入隔空操作后,我看到了一个趋势。手机,以后会有更多的各类传感器。以后的训练数据,将不仅仅是文字、图像和声音,这些传感器的数据也将派上大用。 这就是为什么,「多模融合」是我最期待的方向之一。也就是说,把多模型的信息,统一到一个特征空间当中,之后进行融合训练,这会让感知以及识别更精准。 重要的是,降低开发难度,绝对是一个趋势。 这几年的AI框架迭代,很重要的一方面,就是让开发体验越来越好,应用门槛越来越低。而现在的飞桨已经可以只用5行代码,快速配置GPU进行并行训练了。

在硬件上,NPU也好,神经引擎也好,都在底层上努力,让AI应用发挥更大价值。 在软件上,各类框架疯狂提升模型能力,降低部属难度,提高开发效率。 更重要的是,软件和硬件要互相协调,深度耦合,最终将实现以最低成本达成超高用户体验的目标,赢得全球市场。 这样的软硬结合的移动端发展之路,一定是各大厂今后的角逐舞台。

现当当双十一5折优惠,年度最大促销!

11.8 ~ 11.11 输入下方读者福利优惠券,即可获得200减30额外优惠哦!JQ4BUW 8HBCKK 5UTUBA

评论