CMU清华MIT引爆全球首个Agent无限流,机器人「007」加班自学停不下来!具身智能被革命

新智元报道

新智元报道

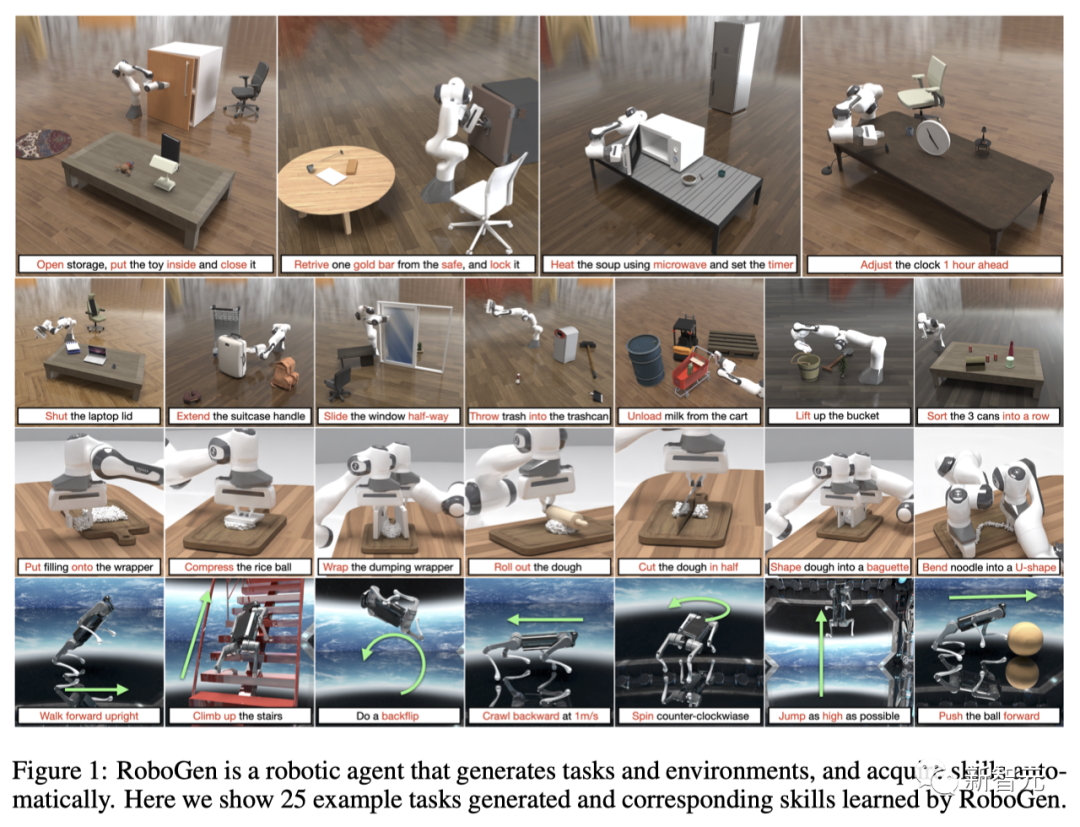

【新智元导读】最近,由CMU/MIT/清华/Umass提出的全球首个生成式机器人智能体RoboGen,可以无限生成数据,让机器人7*24小时永不停歇地训练。AIGC for Robotics,果然是未来的方向。

全球首个生成式机器人Agent发布了!

长久以来,相比于语言或者视觉模型可以在大规模的互联网数据上训练,训练机器人的策略模型需要带有动态物理交互信息的数据,而这些数据的匮乏一直是具身智能发展的最大瓶颈。

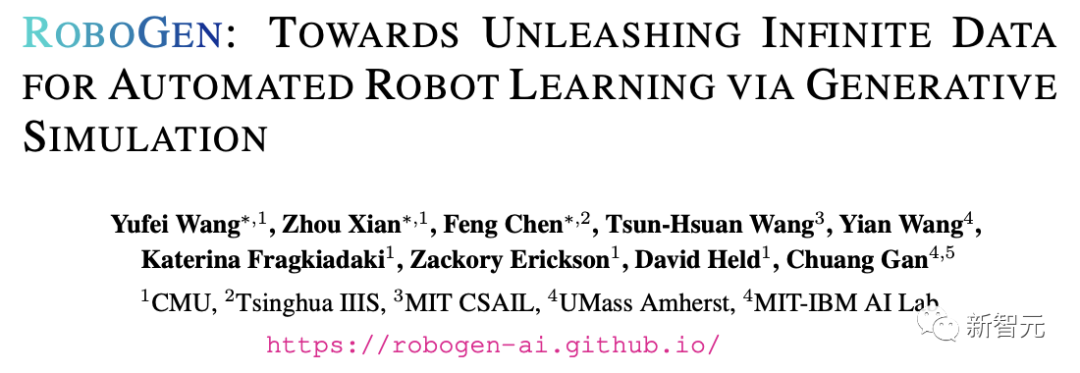

最近,来自CMU、清华、MIT,UMass等机构的研究人员提出了一种全新的RoboGen智能体。

利用涵盖在大语言模型和生成式模型中蕴含的大规模知识,配以逼真模拟世界提供的物理信息,可以「无限」生成各种任务、场景以及教学数据,实现机器人7x24小时全自动训练。

论文地址:https://arxiv.org/abs/2311.01455

项目主页:https://robogen-ai.github.io/

模拟环境,多样化技能学习的关键

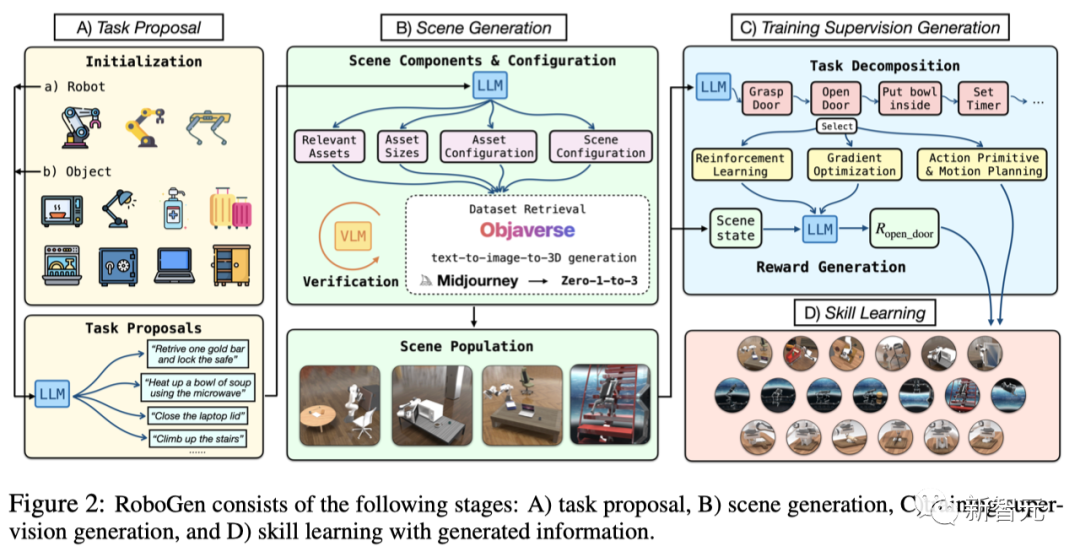

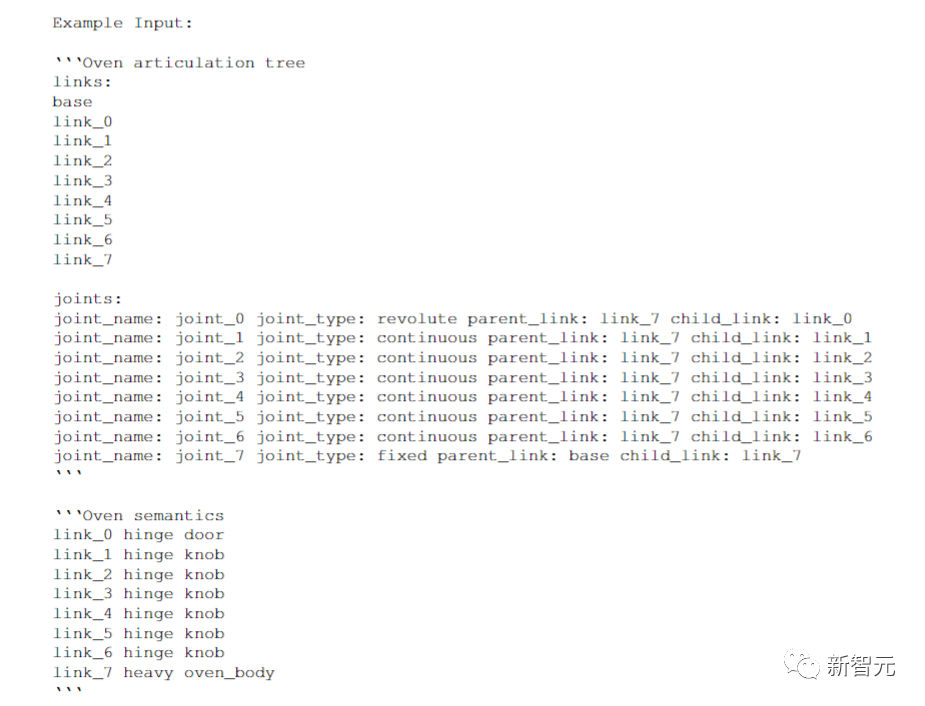

RoboGen流程

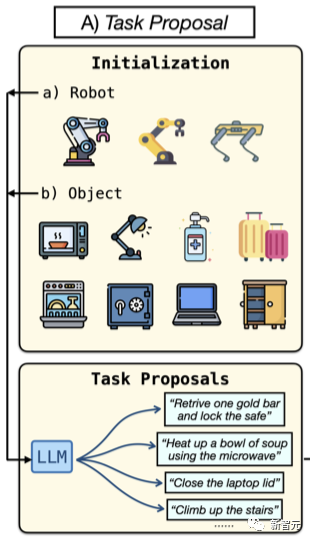

1. 任务建议;

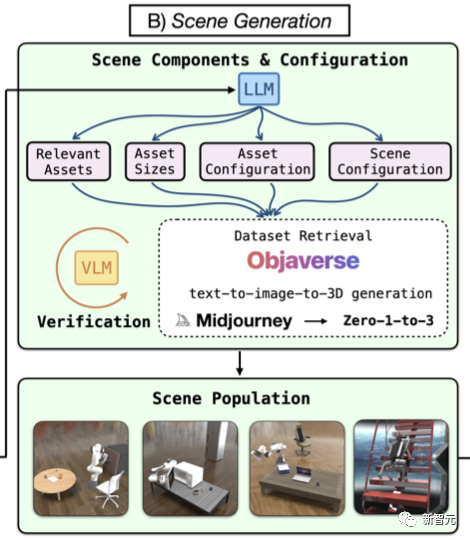

2. 场景生成;

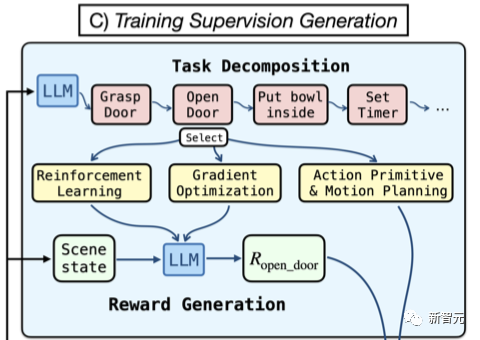

3. 训练监督生成;

任务建议

场景生成

训练监督生成

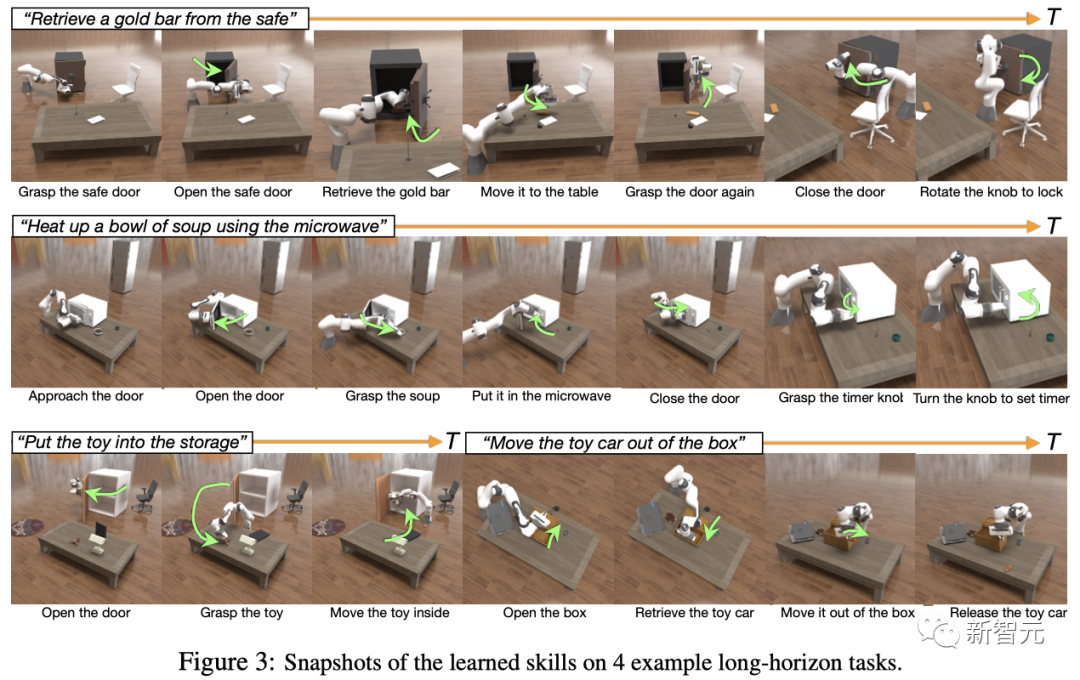

机器人学会开保险箱

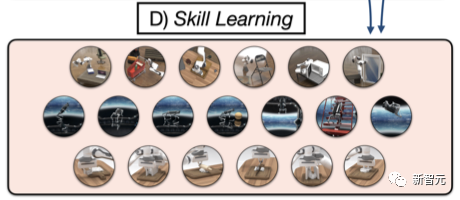

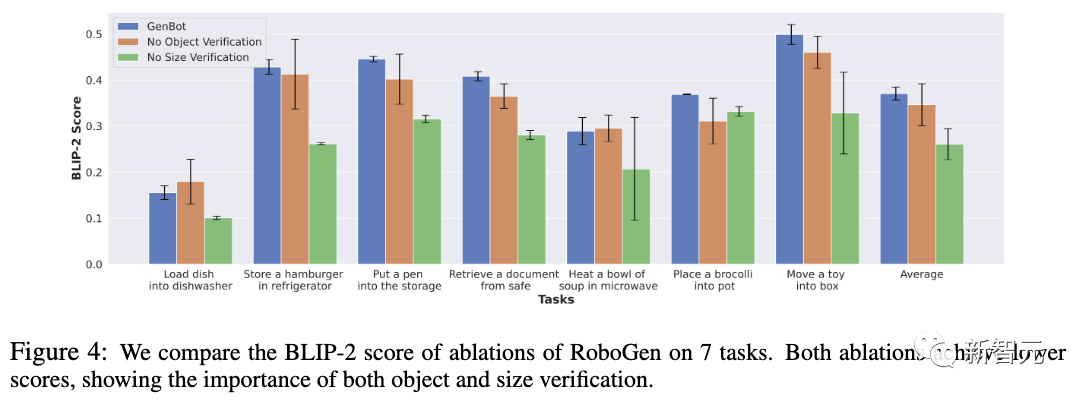

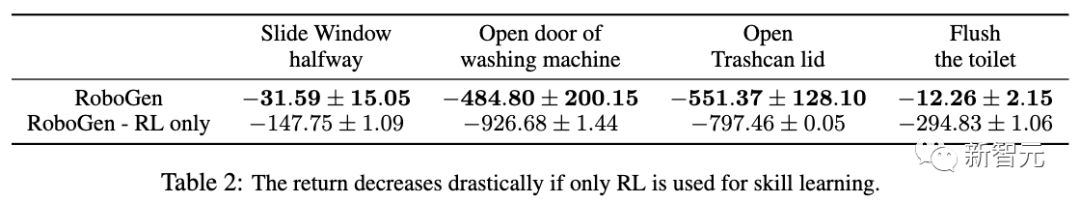

实验结果

作者介绍

评论