FrugalGPT: 用小钱玩转大模型!

共 2197字,需浏览 5分钟

· 2023-05-21

DASOU的学习圈每日分享优秀前沿论文,感兴趣可以加入:

斯坦福大学前两天刚刚发布了一个论文叫FrugalGPT,比较有意思,目前在网上讨论的比较多

大型语言模型(LLMs)是近年来人工智能领域的热门话题,它们可以用来完成各种自然语言处理的任务,比如问答、文本生成、对话等。LLMs通常有数十亿甚至数万亿个参数,需要大量的计算资源和数据来训练和运行。因此,很多公司和机构提供了LLMs的API服务,让用户可以通过付费来查询LLMs的输出。

但是,使用LLMs的API服务也有很多问题,比如:

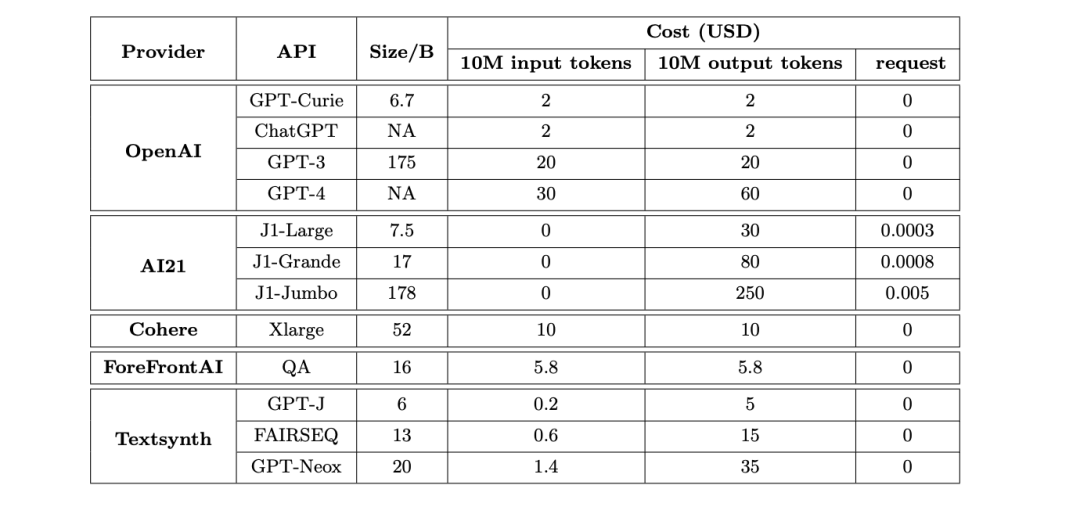

- LLMs的API服务的价格结构不一致,有些按照输入和输出的长度收费,有些按照查询次数收费,有些还有固定的基础费用。这使得用户很难比较不同LLMs的性价比。

- LLMs的API服务的质量也不一致,有些LLMs在某些任务上表现得很好,有些则不尽如人意。这使得用户很难选择适合自己需求的LLMs。

- LLMs的API服务的成本和环境影响也不容忽视,使用最大型的LLMs可能会消耗大量的电力和碳排放。这对于社会福利和可持续发展是不利的。

那么,有没有办法可以用更少的钱使用更好的LLMs呢?这就是本文要介绍的论文《FrugalGPT: How to Use Large Language Models While Reducing Cost and Improving Performance》 的主题和背景。

论文地址:https://arxiv.org/abs/2305.05176

论文动机

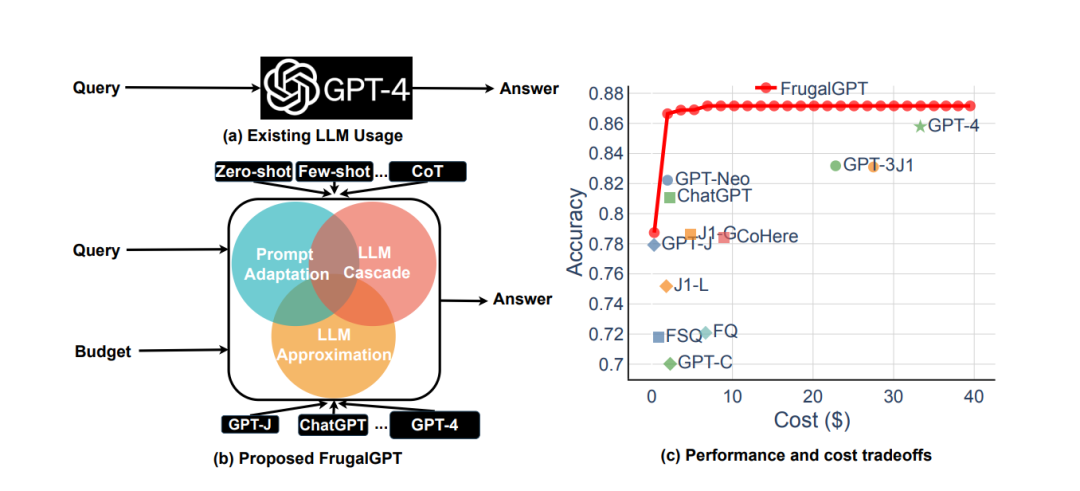

论文的动机是为了帮助用户在使用LLMs时实现成本和性能的优化。论文提出了三种策略:

- 提示适配(prompt adaptation):通过修改输入和输出的格式来适应不同LLMs的特点,从而减少输入和输出的长度,降低费用,并提高准确率。

- LLM近似(LLM approximation):通过使用较小或较便宜的LLMs来近似较大或较贵的LLMs,从而降低费用,并保持一定的准确率。

- LLM级联(LLM cascade):通过组合多个不同大小或价格的LLMs来处理不同难度或类型的查询,从而动态地分配资源,降低费用,并提高准确率。

论文以LLM级联为例,提出了一个简单而灵活的实例化方法,叫做FrugalGPT。

实验细节

论文进行了以下几个方面的实验:

-

论文收集了12个不同大小或价格的商业LLMs(包括GPT-4、ChatGPT、J1-Jumbo等),并比较了它们在四个任务上(包括问答、摘要、情感分析、对话)的性能和价格。

-

论文设计了一个基于强化学习(reinforcement learning)和元学习(meta-learning)的算法,来训练FrugalGPT。FrugalGPT可以根据每个查询的特点,选择一个或多个合适的LLMs,并组合它们的输出,从而达到成本和性能的平衡。

-

论文评估了FrugalGPT在四个任务上与单个LLMs的对比结果,以及与其他两种策略(提示适配和LLM近似)的对比结果。

-

论文分析了FrugalGPT的优势和局限性,以及它对于LLMs的使用和发展的启示和影响。

实验结果

论文的实验结果表明:

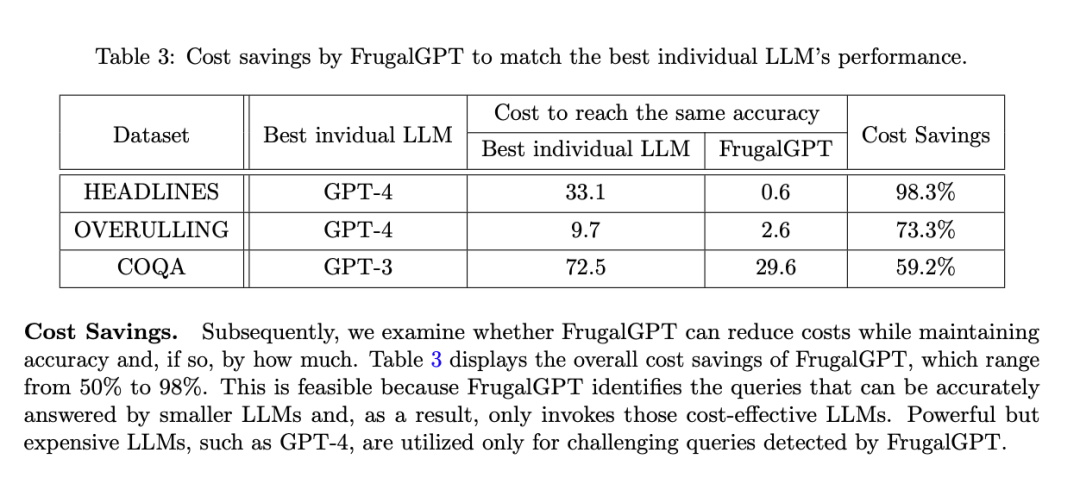

- FrugalGPT可以在不同的任务上匹配或超越最好的单个LLM(例如GPT-4)的性能,同时降低费用高达98%。

- FrugalGPT可以在相同的费用下,提高最好的单个LLM(例如GPT-4)的性能4%。

- FrugalGPT可以比提示适配和LLM近似策略更有效地利用多个LLMs,实现更好的成本和性能的折中。

结语

这篇论文是关于如何用更少的钱使用更好的大型语言模型的,它提出了三种策略,以及一个具体的方法FrugalGPT。FrugalGPT可以根据每个查询的特点,选择和组合不同的LLMs,从而实现成本和性能的优化。FrugalGPT不仅可以为用户节省费用,提高效果,还可以为社会和环境带来好处。